Kurs:Algorithmen und Datenstrukturen (hsrw)/Druckversion

Pseudocode

[Bearbeiten]Pseudocode ist eine neutrale Sprache, die verständlicher und kürzer ist als reale Programmiersprachen. Die Syntax des hier verwendeten Pseudocodes ist an Pascal angelehnt. Darüberhinaus werden einzelne Sprachelemente von Java (z. B. return) verwendet.

Blöcke

[Bearbeiten]Auf die in Java verwendeten geschwungenen Klammern wird verzichtet. Blöcke sind eingerückt. Auf Semikola zum Abschließen von Anweisungen wird verzichtet.

<Kopf des Blocks>

<Anweisung>

<Anweisung>

<Anweisung hinter dem Block>

Bedingte Ausführung

[Bearbeiten]Auch if Bedingungen mit optionalem else Zweig gibt es analog zu Java. Die Spitzen Klammern haben die Bedeutung, dass es sich bei dem entsprechenden Text nicht um ein Schlüsselwort, sondern um einen Ausdruck (Bedingung oder Anweisung) handelt.

if <Bedingung>

<Anweisung>*

[else

<Anweisung>*]

Schleifen

[Bearbeiten]Es gibt die bekannten kopf- und fußgesteuerten Schleifen sowie Schleifen mit fester Anzahl von Durchläufen.

Kopfgesteuerte Schleifen werden mit while realisiert. Im eingerückten Block stehen eine oder mehrere Anweisungen. Dies wird durch den aus der Vorlesung "Grundlagen der Informatik" bekannten Kleene Stern angezeigt, welcher null bis beliebig viele Wiederholungen des vor ihm stehenden Ausdrucks bedeutet.

while <Bedingung>

<Anweisung>*

Schleifen mit fester Anzahl der Durchläufe werden mit for realisiert. Dort wird eine Zählvariable von einem Initialwert in Einerschritten entweder aufwärts oder abwärts bis zum festgelegten Endwert gezählt. Auch hier gibt es einen eingerückten Block mit Anweisungen.

for <Initialwert> to | downto <Endwert>

<Anweisung>*

Weiterhin gibt es eine fußgesteuerte Schleife. Hier in Form der repeat until Schleife. Wir beginnen mit repeat anschließend folgt ein eingerückter Block mit Anweisungen und schließlich das Schlüsselwort until mit der Endbedingung, mit deren Erfüllung die Schleife verlassen wird.

repeat

<Anweisung>*

until <Endbedingung>

Kommentar

[Bearbeiten]Kommentare leiten wir mit dem doppelten Querstrich ein, sie reichen jeweils bis zum Ende der Zeile.

<Anweisung> // <Kommentar> <Anweisung> <Anweisung> // <Kommentar>

Zuweisungen

[Bearbeiten]Bei Zuweisungen orientieren wir uns an der Syntax von Pascal x := 42. Alternativ findet man in der Literatur häufig die Schreibweise x <- 42.

- Zuweisung x := 42

Vergleichsoperatoren

[Bearbeiten]Weiterhin haben wir Vergleichsoperatoren. Hier verwenden wir ein einzelnes Gleichheitszeichen für die Gleichheit und auch in den weiteren Fällen die üblichen mathematischen Symbole.

- Vergleich = ≠ < > ≤ ≥

Für boolesche Ausdrücke haben wir die Schüsselwörter and, or, not und xor.

Boolesche Operatoren

[Bearbeiten]- Boolsche Ausdrücke and or not xor

Typangaben

[Bearbeiten]Typisierung geben wir nur an, sofern sie nicht aus dem Kontext klar wird. Wir orientieren uns hier auch an der Pascalsyntax x : int.

- Typisierung x : int

In Abweichung zur Literatur verwendeten wir nullbasierte Arrays. Der kleinste Index eines Arrays ist bei uns 0, weil wir dies von Java bereits kennen.

Arrays

[Bearbeiten]- Arrays nullbasiert

Als Buch empfehlen wir Ottmann und Widmeyer: Algorithmen und Datenstrukturen.

Beispielhaft geben wir die Maximumsbestimmung im Pseudocode an. Hierzu legen wir einen Zwischenspeicher an, welchen wir mit jedem Element des Arrays vergleichen und auf das aktuelle Element hochsetzen, falls es größer ist als der aktuelle Wert des Zwischenspeichers. Schlussendlich geben wir den Zwischenspeicher zurück.

max(a : array) : int

m := a[0]

for i := 0 to a.length - 1

if a[i] > m

m := a[i]

return m

Die Länge des Arrays a bezeichnen wir analog zu Java mit a.length.

Suchen

[Bearbeiten]Einleitung Suchen

[Bearbeiten]In diesem Kapitel geben wir einen Überblick über das Thema Suchen. Suchprobleme sind eine der häufigsten Probleme in der Informatik. Man kann in sortierten Folgen suchen, Zeichenketten im Text suchen, Dokumente in Textkorpora suchen, oder allgemeine Lösungen von Problemräumen, wie der Spielbaumsuche oder der Plansuche, suchen. Hier behandeln wir zunächst die Suche in sortierten Folgen.

Motivation

[Bearbeiten]Beim Suchen wiederholt man häufig sehr nützliche Beispielalgorithmen, oder lernt diese sogar neu kennen. Außerdem dient es der Vorbereitung der theoretischen Betrachtungen zur Komplexität von Algorithmen. Des weiteren dient es der informellen Diskussion von Entwurfsentscheidungen.

Suchen in sortierten Folgen

[Bearbeiten]- Annahme:

- Die Folge F ist ein Feld mit numerischen Werten. Dazu ist die Folge sortiert, das heißt, wenn i<j, dann ist F[i]<F[j]. Auf das i-te Element hat man Zugriff über F[i]. Es wird nur der Suchschlüssel berücksichtigt.

Ein Beispiel ist ein Telefonbuch, in dem wir nach Namen suchen möchten. Doch wie repräsentiert man diese Daten?

Einschub lineare Datenstrukturen

[Bearbeiten]Definition

[Bearbeiten]Eine lineare Datenstruktur L ist eine Sequenz . Die lineare Datenstruktur ordnet Elemente (entweder primitive Datentypen oder komplexere Datenstrukturen) in einer linearen Anordnung an.

Beispiel

[Bearbeiten]Zahlenfolgen

| 5 | 4 | 6 | 1 | 3 | 2 |

Strings

| L | I | N | E | A | R |

Atomare Operationen

[Bearbeiten]Zu den Operationen gehören Lesen mit

- get(i): Element an Position i lesen

- first(): erstes Element lesen

- last(): letztes Element lesen

- next(e): Element nach Element e lesen

und Schreiben mit

- set(i,e): Element an Position i auf e setzen

- add(i,e): Element e an Position i einfügen

- del(i): Element an Position i löschen

Arrays und Listen

[Bearbeiten]Es gibt zwei Möglichkeiten lineare Datenstrukturen zu realisieren. Entweder Arrays oder (verlinkte) Listen. Arrays belegen einen zusammenhängenden Bereich im Speicher. Elemente einer verlinkten Liste können beliebig verteilt sein. Ob zur Realisierung einer linearen Datenstruktur ein Array oder eine Liste verwendet wird, hängt von der Anwendung ab. Arrays werden meist für statische Datenstrukturen verwendet, d.h. wenn die Länge des Arrays nicht verändert wird. Listen werden meist für dynamische Datenstrukturen verwendet, d.h. wenn die Länge variabel ist. Zu den positiven Eigenschaften von Arrays zählen der schneller Zugriff auf Einzelelemente durch den Index. Zu den negativen Eigenschaften von Arrays zählen das sehr aufwändige Einfügen der Elemente. Zu den positiven Eigenschaften von Listen zählen die relativ effiziente Manipulation, zu den negativen Eigenschaften der ineffiziente Direktzugriff.

Einfache verlinkte Liste von Zahlen in Java

[Bearbeiten]public class IntegerList {

private class IntegerListElement{

int value;

IntegerListElement next;

}

IntegerListElement first;

int size = 0;

private IntegerListElement getElement(int i){

if(i+1 > size)

throw new IllegalArgumentExcepHon();

int idx = 0;

IntegerListElement current = first;

while(idx != i){

current = current.next;

idx ++;

}

return current;

}

public int get(int i){

return this.getElement(i).value;

}

public int add(int pos, int val){

IntegerListElement newElem = new IntegerListElement();

newElem.value = val;

if(pos > 0){

IntegerListElement e = this.getElement(pos‐1);

newElem.next = e.next;

e.next = newElem;

}else{

newElem.next = this.first;

this.first = newElem;

}

Suchen und Sortieren

[Bearbeiten]Suchen und Sortieren sind voneinander abhängige Operationen. Dabei gibt es zwei Ansätze: Wenn Elemente nie sortiert sind, dann ist die Suche sehr aufwändig. Wenn die Elemente sortiert sind, wird die Suche erleichtert, jedoch kann das Sortieren an sich sehr aufwändig sein. Wenn Elemente hinzugefügt oder gelöscht werden ist diese Problematik noch sichtbarer. Nur ein unsortiertes Element macht die Suche aufwändig, doch bei jeder Einfügung oder Löschung zu sortieren ist ebenfalls sehr aufwändig. Spezielle dynamische Datenstrukturen erlauben eine automatische und effiziente Sortierung bei Einfügung oder Löschung.

Lineare Datenstruktur in Java

[Bearbeiten]- Arrays:

- int[] arr = new int[10];

- arr[1] = 4;

- Listen:

- List<Integer> myList = new LinkedList<Integer>();

- myList.add(5);

- Neben LinkedList unterstützt Java eine Reihe weiterer Listenimplementierungen mit unterschiedlichen Vor- und Nachteilen

- Schnittstelle List<Type> beinhaltet die gemeinsamen Methoden

Suche

[Bearbeiten]- Problembeschreibung

- Die Eingabe ist eine Folge F mit n Elementen von Zahlen und Suchelementen k. Die Ausgabe ist eine erfolgreiche oder nicht erfolgreiche Suche. Erfolgreich ist sie, wenn der Index p ist. Eventuell muss man festlegen, was bei Mehrfachvorkommen passiert. Normalerweise gilt dann das erste Vorkommen. Ist die Suche nicht erfolgreich, dann ist die Ausgabe -1.

- Merkmale der Suche

- Es gibt immer einen Suchschlüssel für Suchelemente, z.B. Zahlen. Außerdem ist eine Suche immer erfolgreich oder erfolglos. Die Suche basiert auf Vergleichsoperationen und die Daten sind zunächst als Feld, bzw. Array, oder Liste dargestellt.

Suchverfahren

[Bearbeiten]In den nachfolgenden Kapiteln lernen Sie die sequentielle, binäre und Fibonacci Suche kennen.

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5 zu finden.

Lineare Suche

[Bearbeiten]Dieses Kapitel handelt von der linearen oder sequentiellen Suche. Die Idee dieses Suchalgorithmus ist, dass zuerst das erste Elemente der Liste mit dem gesuchten Elemente verglichen wird, wenn sie übereinstimmen wird der aktuelle Index zurückgegeben. Wenn nicht wird der Schritt mit dem nächsten Element wiederholt. Sollte das gesuchte Element bis zum Ende der Folge nicht gefunden werden, war die Suche erfolglos und -1 wird zurückgegeben.

Algorithmus

[Bearbeiten]

int SeqSearch(int[] F, int k) {

/ * output: Position p (0 ≤ p ≤ n-1) */

}

int n = F.length;

for (int i = 0; i < n; i++) {

if (F[i] == k) {

return i;

}

return -1; }

Dabei ist Int[] die sortierte Folge von int, int k der Suchschlüssel und die Folge F hat die Länge n.

Aufwands Analyse

[Bearbeiten]Das Terminierungs-Theorem besagt, dass der Algorithmus SeqSearch für eine endliche Eingabe nach endlicher Zeit terminiert. Das Korrektheits-Theorem besagt, falls das Array F ein Element k enthält, gibt SeqSearch(F,k) den Indes des ersten Vorkommens von k zurück. Ansonsten gibt SeqSearch(F,k) den Wert -1 zurück Im besten Fall beträgt die Anzahl der Vergleiche 1, das heißt direkt bei dem ersten Suchdurchlauf wird der Suchschlüssel gefunden. Im schlechtesten Fall beträgt die Anzahl der Vergleiche n, das heißt im letzten Suchdurchlauf wird der Suchschlüssel gefunden. Der Durchschnitt bei einer erfolgreichen Suche beträgt (n+1)/2 und der Durchschnitt einer erfolglosen Suche n. Die Folgen müssen nicht sortiert sein. Der Algorithmus SeqSearch hat also eine Worst-Case Laufzeit von .

Sequentielle Suche in Java

[Bearbeiten]

public class SequentialSearch{

public final static int NO_KEY = -1;

static int SeqSearch(int[] F, int k) {

for (int i = 0; i < F.length; i++){

if (F[i] == k)

return i;

} return NO_KEY;

}

public static void main(String[ ] args){

if (args.length != 1) {

System.out.println(''usage: SequentialSearch

<key>'');

return;

}

int[ ] f = {2, 4, 5, 6, 7, 8, 9, 11};

int k = Integer.parseInt(args[0]);

System.out.println(''Sequentiell:“+seqSearch(f,k));

}

}

In der Klasse SeqSearch ist eine Konstante NO_KEY definiert, die als Ergebnis zurückgegeben wird, wenn der gesuchte Wert nicht im Feld gefunden wurde. Die Methode search wird schließlich in der Klassenmethode main aufgerufen, um das Feld f nach dem Schlüsselwert k zu durchsuchen. Dieser Wert ist als Parameter beim Programmaufruf anzugeben. Da die Programmparameter als Feld args von Zeichenketten übergeben werden, ist zuvor noch eine Konvertierung in einen int-Wert mit Hilfe der Methode parseInt der Klasse java.lang.Integer vorzunehmen. Somit bedeutet der Programmaufruf "java SeqSearch 4" die Suche nach dem Wert 4 in der gegebenen Folge. Der Aufruf erfolgt mit java SequentialSearch 4

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.1.1 zu finden.

Binäre Suche

[Bearbeiten]Dieses Kapitel behandelt die binäre Suche. Wir stellen uns die Frage, wie die Suche effizienter werden könnte. Das Prinzip der binären Suche ist zuerst den mittleren Eintrag zu wählen und zu prüfen ob sich der gesuchte Wert in der linken oder rechten Hälfte der Liste befindet. Anschließend fährt man rekursiv mit der Hälfte fort, in der sich der Eintrag befindet. Voraussetzung für das binäre Suchverfahren ist, dass die Folge sortiert ist. Das Suchverfahren entspricht dem Entwurfsmuster von Divide-and-Conquer.

Beispiel

[Bearbeiten]Rekursiver Algorithmus

[Bearbeiten]int BinarySearch(int[] F, int k){

/*input: Folge F der Länge n, Schlüssel k */

/*output: Position p */

return BinarySearchRec(F, k, 0, F.length-1); //initialer Aufruf

}

int BinarySearchRec (int[] F, int k, int u, int o) {

/* input: Folge F der Länge n, Schlüssel k,

untere Schranke u, obere Schranke o */

/* output: Position p */

m = (u+o)/2;

if (F[m] == k) return m;

if ( u == o) return -1;

if (F[m] > k) return BinarySearchRec(F,k,u,m-1);

return BinarySearchRec(F,k,m+1,o);

}

Aufwands Analyse

[Bearbeiten]Das Terminierungs-Theorem besagt, dass der Algorithmus BinarySearch für jede endliche Eingabe F nach endlicher Zeit terminiert. In jedem Rekursionsschritt verkürzt sich die Länge des betrachteten Arrays F um mehr als die Hälfte. Nach endlichen vielen Schritten hat das Array nur noch ein Element und die Suche endet entweder erfolgreich oder erfolglos. Falls das Element vorher gefunden wird terminiert der Algorithmus schon früher.

Das Korrektheits-Theorem besagt, dass falls das Array F ein Element k enthält, gibt BinarySearch(F.k) den Index eines Vorkommens von k zurück. Ansonsten gibt BinarySearch (F,k) den Wert ‐1 zurück. Beweisen kann man das durch die verallgemeinerte Induktion nach der Länge n von F. n=1: Der erste Aufruf von BinarySearchRec ist BinarySearchRec(F,k,0,0) und somit m=0. Ist F[0]=k so wird 0 zurückgegeben, ansonsten ‐1 da 0=0. n>1: Der erste Aufruf von BinarySearchRec ist BinarySearchRec(F,k,0,n‐1) und somit m=(n‐1)/2. Ist F[m]=k, so wird m zurückgegeben. Ansonsten wird rekursiv auf F[0...m‐1] oder F[m+1...n] fortgefahren. Da die Folge sortiert ist, kann k nur in einem der beiden Teile vorhanden sein.

Da die Liste nach jedem Aufruf halbiert wird, haben wir nach dem ersten Teilen der Folge noch n/2 Elemente, nach dem zweiten Schritt n/4 Elemente, nach dem dritten Schritt n/8 Elemente... daher lässt sich allgemein sagen, dass in jedem i-ten Schritt maximal Elemente, das heißt Vergleiche bei der Suche. Im besten Fall hat die Suche nur einen Vergleich, weil der Suchschlüssel genau in der Mitte liegt. Im schlechtesten Fall und im Durchschnitt für eine erfolgreiche und eine erfolglose Suche liegt die Anzahl der Vergleiche bei .

Rekursionsgleichung

[Bearbeiten]Für die erfolglose Suche ergibt sich folgende Rekursionsgleichung.

Das Auflösen von T(n) nach Induktion ergibt eine Laufzeit für eine erfolglose, also Worst-Case, Suche.

Iterativer Algorithmus

[Bearbeiten]int BinarySearch(int[] F, int k) {

/* input: Folge F der Länge n, Schlüssel k */

/* output: Position p (0 ≤ p ≤ n-1) */

int u = 0;

int o = F.length-1;

int m;

while (u <= o) {

m = (u+o)/2;

if (F[m] == k)

return m;

else

if (k < F[m])

o = m-1;

else

u = m+1;

}

return -1;

}

Der erste Teil des Algorithmus ist die Initialisierung. Die while Schleife, besagt, dass so lange wiederholt werden soll, bis die angegebenen Schranken erreicht sind. Die if Anweisung ist die Abbruchbedingung. Der letzte Teil des Algorithmus (else) passt die obere, bzw. untere Schranke an.

Vergleich der Suchverfahren

[Bearbeiten]| Verfahren / #Elemente | ||||

|---|---|---|---|---|

| sequenziell (n/2) | ||||

| binär |

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.1.2 zu finden.

Komplexität

[Bearbeiten]Einführung Komplexität

[Bearbeiten]Auf dieser Seite wird das Thema Komplexität behandelt. Gegeben ist ein zu lösendes Problem. Es ist wünschenswert, dass der Algorithmus zur Berechnung der Lösung einen möglichst geringen Aufwand hat. Daher wird der Aufwand des Algorithmus (Komplexität) abgeschätzt . Zur Lösung von Problemen einer bestimmten Klasse gibt es einen Mindestaufwand.

Motivierendes Beispiel

[Bearbeiten]Als Beispiel nutzen wir die sequentielle Suche in Folgen. Gegeben ist die Zahl b und n Zahlen, z.B. mit A[0...n-1] mit n>0, wobei die Zahlen verschieden sind. Gesucht ist ein Index , falls der Index existiert, sonst ist i = n. Die Lösung für das Problem ist:

i = 0;

while (i < n && b != A[i])

i++;

Der Aufwand der Suche hängt nun von der Eingabe ab, d.h vom gewählten Wert n, den Zahlen A[0],...,A[n] und von b. Es gibt zwei Möglichkeiten, eine erfolgreiche oder eine erfolglose Suche. Eine erfolgreiche Suche haben wir, wenn b=A[i] dann ist S=i+1 Schritte. Ist die Suche jedoch erfolglos, dann ist S=n+1 Schritte. Das Problem ist, dass die Aussage von zu vielen Parametern abhängt und unser Ziel ist eine globale Aussage zu finden, die nur von einer einfachen Größe abhängt, z.B. der Länge n der Folge.

Analyse erfolgreiche Suche

[Bearbeiten]Im schlechtesten Fall wird b erst im letzten Schritt gefunden, d.h. b=A[n-1]. Dann wäre S=n. Im Mittel wird die Anwendung mit verschiedenen Eingaben wiederholt. Wenn man beobachtet wie oft b an erster, zweiter,..., letzter Stelle gefunden wird, hat man eine Annahme über die Häufigkeit. Läuft der Algorithmus k mal (k>1), so wird b gleich oft an erster, zweiter,....,letzter Stelle gefunden und somit k/n mal an jeder Stelle. Die Anzahl der Schritte insgesamt für k Suchvorgänge lässt sich folgendermaßen berechnen:

Für eine Suche benötigt man Schritte Daraus folgt, dass im Mittel ( bei einer Gleichverteilung)

Asymptotische Analyse

[Bearbeiten]Zur Analyse der Komplexität geben wir eine Funktion als Maß für den Aufwand an. . Das bedeutet f(n)=a bei Problemen der Größe n beträgt der Aufwand a. Die Problemgröße ist der Umfang der Eingabe, wie z.B. die Anzahl der zu sortierenden oder zu durchsuchenden Elemente. Der Aufwand ist die Rechenzeit( Abschätzung der Anzahl der Operationen, wie z.B. Vergleiche) und der Speicherplatz.

Aufwand für Schleifen

[Bearbeiten]Wie oft wird die Wertezuweisung x=x+1 in folgenden Anweisungen ausgeführt?

x = x +1

1-mal

for (i = 1; i <= n; i++)

x = x + 1;

n-mal

for (i = 1; i <= n; i++)

for (j = 1; j <= n; j++)

x = x + 1;

-mal

Aufwandsfunktion

[Bearbeiten]Die Aufwandsfunktion ist meist nicht exakt bestimmbar. Daher wird der Aufwand im schlechtesten Fall und im mittleren Fall abgeschätzt und die Größenordnung ungefähr errechnet.

Vergleich Größenordnung

[Bearbeiten]| Funktion | n=100 | n=10.000 | n=100.000 |

| log n | 4,6 | 9,2 | 11,5 |

| 10.000 | 100.000.000 | 10.000.000.000 | |

| 1.000.000 |

Problemstellung

[Bearbeiten]Wie können wir das Wachstum von Funktionen abschätzen und wie verhalten sich die Funktionen zueinander? Das Ziel ist, die Funktion zu wählen, die nach oben beschränkt.

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.3 zu finden.

O-Notation

[Bearbeiten]Auf dieser Seite wird die O-Notation behandelt. Bei der O-Notation werden die asymptotischen oberen Schranke für Aufwandsfunktion angegeben. Das heißt deren Wachstumsgeschwindigkeit bzw. Größenordnung. Eine Asymptote ist eine Gerade, der sich eine Kurve bei immer größer werdender Entfernung vom Koordinatenursprung unbegrenzt nähert. Eine einfache Vergleichsfunktion ist für Aufwandsfunktionen mit

Definition

[Bearbeiten]Für eine Funktion ist die Menge wie folgt definiert:

Anschaulich formuliert bedeutet das, dass O(f(n)) die Menge aller durch f nach oben beschränkter Funktionen ist und somit die asymptotische obere Schranke ist.

Die Definition veranschaulichst sieht folgendermaßen aus:

Das heißt g wächst nicht schneller als f. Das bedeutet wiederrum ist für genügend große n durch eine Konstante c nach oben beschränkt.

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.3.2 zu finden.

-Notation

[Bearbeiten]Für eine Funktion ist die Menge wie folgt definiert:

Anschaulich formuliert bedeutet das, dass die Menge aller durch f nach unten beschränkter Funktionen ist und somit die asymptotische untere Schranke ist.

-Notation

[Bearbeiten]Die exakte Ordnung von f(n) ist definiert als:

Oder etwas kompakter:

Anschaulich formuliert bedeutet das, dass die Menge aller durch f nach unten und oben beschränkter Funktionen und somit die asymptotische untere und obere Schranke ist.

Beweis

[Bearbeiten]Zu zeigen:

Zeige

Beispiel 1

[Bearbeiten]Wir stellen uns die Frage, ob bzw. ob eine obere Schranke für ist. Die Antwort ist ja. Die Begründung dazu lautet folgendermaßen:

Beispiel 2

[Bearbeiten]Wir stellen uns die Frage, ob bzw. ob eine obere Schranke für ist. Die Antwort ist nein. Beweisen kann man das durch Widerspruch. Unsere Annahme ist:

Wähle Widerspruch!!

Notation Eigenschaften

[Bearbeiten]Lemma

[Bearbeiten]Für beliebige Funktionen f,g gilt:

Beweis in beide Richtungen

[Bearbeiten]

Als erstes machen wir den Beweis nach rechts ()

nun der Beweis nach links ()

Beispiel

[Bearbeiten]

Lemma

[Bearbeiten]1. 2. 3.

Beweis in beide Richtungen

[Bearbeiten]Beweis zu 1. nach rechts ()

Beweis zu 1. nach links ()

(siehe Definition)

und sei t(n) ein beliebiges Element der Menge O(f(n))

(siehe Definition)

(Definition der Teilmenge, da t(n) ein beliebiges Element ist)

Beispiele

[Bearbeiten]

Damit ist

Damit ist

Damit ist

Lemma

[Bearbeiten]Falls , dann ist auch .

Beweis

[Bearbeiten]

Dabei ist eine Konstante.

Beispiel

[Bearbeiten]

Lemma

[Bearbeiten]1. 2.

Ein häufiges Problem sind Grenzwerte der Art oder Bei diesem Problem kann man als Ansatz die Regel von de l'Hospital verwenden.

Satz(Regel von de L'Hospital) Seien f und g auf dem Intervall differenzierbar. Es gelte und es existiere . Dann existiert auch und es gilt:

Beispiel

[Bearbeiten]1.

2.

Beim zweiten Beispiel musste die Regel von de l'Hospital wiederholt angewandt werden.

Lemma

[Bearbeiten]Gibt es immer eine Ordnung zwischen den Funktionen? Es gibt Funktionen f und g mit . Ein Beispiel sind die Funktionen sin(n) und cos(n).

Für alle

Beweis durch Widerspruch

[Bearbeiten]Wir nehmen an, dass ,

das heißt .

Aber es muss auch gelten,

das heißt

Komplexitätsklassen

[Bearbeiten]Auf dieser Seite werden die Komplexitätsklassen behandelt.

Wir sagen sei Und wir sagen, ein Algorithmus mit Komplexität f(n) benötigt höchstens polynomielle Rechenzeit, falls es ein Polynom p(n) gibt, mit . Des weiteren sagen wir, dass ein Algorithmus höchstens exponentielle Rechenzeit benötigt, falls es eine Konstante gibt, mit .

Die Komplexitätsklassen sind:

| der konstante Aufwand, das bedeutet der Aufwand ist nicht abhängig von der Eingabe | |

| der logarithmische Aufwand | |

| der lineare Aufwand | |

| der quadratische Aufwand | |

| der polynomiale Aufwand | |

| der exponentielle Aufwand |

Wachstum

[Bearbeiten]| f(n) | n=2 | ||||

| ldn | 1 | 4 | 8 | 10 | 20 |

| n | 2 | 16 | 256 | 1024 | 1048576 |

| 2 | 64 | 2048 | 10240 | 20971520 | |

| 4 | 256 | 65536 | 1048576 | ||

| 8 | 4096 | 16777200 | |||

| 4 | 65536 |

Zeitaufwand

[Bearbeiten]Nun stellen wir uns die Frage, wie groß bezüglich der Rechenschritte darf, oder kann ein Problem sein, je nach Komplexitätsklasse, wenn die Zeit T begrenzt ist? Wir nehmen an, dass wir pro Schritt eine Rechenzeit von brauchen. In der folgenden Tabelle steht T für die Zeitbegrenzung und G für die maximale Problemgröße.

| G | T=1Min. | 1 Std. | 1 Tag | 1 Woche | 1 Jahr |

| n | |||||

| 7750 | |||||

| 391 | 1530 | 4420 | 8450 | 31600 | |

| 25 | 31 | 36 | 39 | 44 |

Ein Beispiel ist für T=1 Min. :

Typische Problemklassen

[Bearbeiten]| Aufwand | Problemklasse |

|---|---|

| für einige Suchverfahren für Tabellen (Hashing) | |

| für allgemeine Suchverfahren für Tabellen (Baum-Suchverfahren) | |

| für sequenzielle Suche, Suche in Texten, syntaktische Analyse von Programmen (bei "guter" Grammatik) | |

| für Sortieren | |

| für einige dynamische Optimierungsverfahren (z.B. optimale Suchbäume), einfache Multiplikation von Matrix-Vektor | |

| für einfache Matrizen Multiplikationen | |

| für viele Optimierungsprobleme (z.B. optimale Schaltwerke), automatisches Beweisen (im Prädikatenkalkül 1.Stufe) |

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.3.3 zu finden.

Aufwandsanalyse von iterativen Algorithmen

[Bearbeiten]Auf dieser Seite wird der Aufwand von iterativen Algorithmen analysiert. Als Aufwand wird die Anzahl der durchlaufenen Operationen zur Lösung des Problems bezeichnet ( Zuweisungen, Vergleiche...). Häufig ist der Aufwand abhängig vom Eingabeparameter (Problemgröße). Die Aufwandsklasse sagt, wie der Aufwand in Abhängigkeit von der Problemgröße wächst. Doch wie kann man nun bei beliebigem Java Code die Aufwandsklasse bestimmen?

Aufwand von Programmen ablesen

[Bearbeiten]void alg1(int n){

int m = 2;

int i;

int k = n;

while (n > 0){

i = k;

while (i > 0) {

m = m + i;

i = i / 2;

}

n = n - 1;

}

}

Die Aufwandsklasse ist . Die äußere Schleife wird n-mal durchlaufen und die Innere Schleife log n-mal.

void alg1(int n) {

int m = 1;

int i = 0;

while (m < n) {

while (i < m)

i = i + 1;

m = m + i;

}

}

Hier ist die Aufwandsklasse O(n+log n). In jedem Durchlauf der äußeren Schleife wird m verdoppelt, d.h. sie läuft log n Mal. Die innere Schleife läuft bis n/2, aber nicht jedes Mal, weil i nur ein Mal auf 0 gesetzt wird. Man könnte als Aufwandsklasse auch O(n) sagen, da der Summand log n nicht ins Gewicht fällt.

Bestandteile iterativer Algorithmen

[Bearbeiten]Zum einen haben wir elementare Anweisungen wie Zuweisungen und Vergleiche. Diese haben einen Aufwand von 1.

Des Weiteren haben wir Sequenzen oder auch geschrieben. Die obere Grenze ist und die untere Grenze ist . Dabei ist der Aufwand, der bei der Ausführung von entsteht.

Ein weiterer Bestandteil ist die Selektion. . Hier ist die obere Grenze und die untere Grenze .

Außerdem haben wir Iterationen . Hierbei ist die obere und die untere Grenze die Anzahl der Schleifendurchläufe, und die untere Grenze . Doch wie ist der Aufwand für eine for-Schleife? Ein Beispiel ist . Die Antwort ist die Abbildung auf eine while-Schleife.

while(B) {

}

Beispiel Sequenz

[Bearbeiten]public int berechne(int n) {

int x = 0;

x = x + 1;

return x;

}

Jede Zeile hat den Aufwand . Wie viele Operationen werden nun durchlaufen? Und ist die Anzahl abhängig vom Eingabeparameter? Der Aufwand ist

Die Aufwandsklasse ist somit

Beispiel Schleifen

[Bearbeiten]public int berechne(int n) {

int x = 0;

for (int i=0; i < n; i++) {

x = x + 1;

}

return x;

}

Die for Schleife hat den Aufwand . Die Initialisierung und das return haben jeweils den Aufwand .

Der Gesamtaufwand ist somit . Somit ist die Aufwandsklasse .

public int berechne(int n) {

int x = 0;

for (int i=0; i < n; i++) {

for (int j=0; j < n; j++) {

x = x + 1;

}

}

return x;

}

Hier hat die for-Schleife den Aufwand und die Initialisierung und das return wieder . Damit ergibt der sich Gesamtaufwand . Daraus folgt die Aufwandsklasse .

Beispiel Selektion

[Bearbeiten]public int berechne(int n) {

if (n % 2 == 0) {

int x = 0;

for (int i=0; i < n; i++) {

x = x + 1;

}

return x;

}else{

return n;

}

}

Hier hat die for-Schleife einen Aufwand von . Die Initialisierung und das return wieder .

Die obere Grenze ist somit und die untere Grenze

Faustregeln

[Bearbeiten]Zu den häufig verwendeten Faustregeln gehört, dass wenn wir keine Schleife haben, der Aufwand konstant ist. Eine weitere ist, dass bei einer Schleife immer ein linearer Aufwand vorliegt. Bei zwei geschachtelten Schleifen haben wir immer einen quadratischen Aufwand. Doch die Faustegeln gelten nicht ohne Ausnahmen. Besonders Acht geben muss man bei Aufwandsbestimmungen für Schleifen, bei mehreren Eingabevariablen, bei Funktionsaufrufen und bei Rekursionen.

Aufwandsbestimmung für Schleifen

[Bearbeiten]public int berechne(int n) {

int x = 0;

for (int i=0; i < 5; i++) {

x = x + 1;

}

return x;

}

Der Schleifenabbruch hängt nicht vom Eingabeparameter ab. Der Aufwand beträgt somit haben wir die Aufwandsklasse

public int berechne(int n) {

int x = 0;

for (int i=1; i < n; i = 2*i) {

x = x + 1;

}

return x;

}

Hier wächst die Laufvariable nicht linear an.Daher ist der Aufwand und wir haben die Aufwandsklasse .

Doch gibt es eine allgemeine Methodik zum Bestimmen des Schleifenaufwands?

for (int i=1; i < n; i=2*i) {

x = x + 1;

}

Schritt 1: Wie entwickelt sich hier die Laufvariable? Der Startwert i ist 1 und die Veränderung in jedem Schritt ist . Die Laufvariable entwickelt sich somit wie folgt:

Nach dem 1. Durchlauf

Nach dem 2. Durchlauf

Nach dem 3. Durchlauf

Nach dem k. Durchlauf

Schritt 2: Nach wie vielen Durchläufen wird die Schleife abgebrochen?

Der Abbruch erfolgt, wenn

:

Somit erfolgt ein Abbruch nach ⌈ ⌉ Durchläufen.

public int berechne(int[] f1, int[] f2) {

int result = 0;

for (int i=0; i < f1.length; i++) {

for (int j=0; j < f2.length; j++) {

if (f1[i] == f2[j]) result++;

}

}

return result;

}

Hier haben wir nun eine for Schleife mit mehreren Eingabevariablen. Die Problemgrößen sind .

public int berechne2(int[] f1, int[] f2){

f2 = mergeSort(f2);

int result = 0;

for (int i=0; i < f1.length; i++) {

if (binarySearch(f2, f1[i])) result++;

}

return result;

}

Der Aufwand ist hier . Somit ist die Aufwandsklasse .

In diesem Beispiel haben wir wieder mehreren Eingabevariablen. Diese sind die gleichen Problemgrößen .

public int berechne2(int[] f1, int[] f2){

int result = 0;

for (int i=0; i < f1.length; i++) {

for (int j=0; j < f2.length; j++) {

if (f1[i] == f2[j]) result++;

}

}

return result;

}

Der Aufwand ist hier wie folgt: . Somit ist die Aufwandsklasse .

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.3.4 zu finden.

Aufwandsanalyse von rekursiven Algorithmen

[Bearbeiten]Auf dieser Seite wird der Aufwand von rekursiven Algorithmen untersucht.

public int fib(int n) {

if (n == 0 || n == 1) {

return 1;

} else {

return fib(n-1) + fib(n-2);

}

}

Wie ist nun der Aufwand für Fibonacci? Bei Rekursionsabbruch und im Rekursionsfall . Zur Bestimmung benutzen wir Rekursionsgleichungen.

Rekursionsgleichungen

[Bearbeiten]Eine Rekursionsgleichung ist eine Gleichung oder Ungleichung, die eine Funktion anhand ihrer Anwendung auf kleinere Werte beschreibt.

Rekursionsgleichung für Fibonacci:

Lösung von Rekursionsgleichungen

[Bearbeiten]Die Frage ist nun welche Aufwandklasse T(n) beschreibt. Dies könnten alle möglichen Aufwandsklassen sein. Methoden um dieses Problem zu lösen sind die vollständige Induktion und das Master-Theorem.

Spezialfall Divide and Conquer Algorithmus

[Bearbeiten]Ein Divide-and-Conquer Algorithmus stellt im Allgemeinen eine einfache, rekursive Version eines Algorithmus dar und hat drei Schritte:

- Divide: Unterteile das Problem in eine Zahl von Teilproblemen

- Conquer: Löse das Teilproblem rekursiv. Wenn das

Teilproblem klein genug ist, dann löse das Teilproblem direkt (z.B. bei leeren oder einelementigen Listen)

- Combine: Die Lösungen der Teilprobleme werden zu einer Gesamtlösung kombiniert.

Merge Sort ist beispielsweise ein Divide and Conquer Algorithmus.

- Divide: Zerteile eine Folge mit n Elementen in zwei Folgen mit je n/2 Elementen.

- Conquer: Wenn die resultierende Folge 1 oder 0 Elemente enthält, dann ist sie sortiert.Ansonsten wende Merge Sort rekursiv an.

- Combine: Mische die zwei sortierten Teilfolgen.

public List mergeSort(List f) {

if (f.size() <= 1) {

return f;

} else {

int m = f.size() / 2;

List left = mergeSort(f.subList(0,m));

List right = mergeSort(f.subList(m,f.size());

return merge(left, right);

}

}

Die dazugehörige Rekursionsgleichung lautet:

Im Allgemeinen ist die Rekursionsgleichung für Divide and Conquer Algorithmen:

mit D(n) als Aufwand für Divide, T(n/b) als Aufwand für Conquer und C(n) als Aufwand für Combine.

Ab- und Aufrunden

[Bearbeiten]Die Rekursionsgleichung von MergeSort beschreibt den Aufwand für den schlechtesten Fall.

Aber die Annahme, dass n eine geeignete ganze Zahl ist ergibt normalerweise das gleiche Ergebnis wie

eine beliebige Zahl mit Auf- bzw. Abrunden. Dies führt zur einfacheren Rekursionsgleichung:

Beispiel Binäre Suche

[Bearbeiten]public List binarySearch(ArrayList<Integer> f, int e) {

if (f.size() == 0) {

return -1;

} else {

int m = f.size() / 2;

if (f.get(m) == e) {

return m;

} else if (f.get(m) < e) {

return binarySearch(f.subList(0, m), e);

} else {

return binarySearch(f.subList(m+1, f.size()), e);

}

}

}

Die Rekursionsgleichung lautet

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.3.4 zu finden.

Vollständige Induktion

[Bearbeiten]Auf dieser Seite wird die vollständige Induktion behandelt. Es handelt sich hierbei um eine rekursive Beweistechnik aus der Mathematik. Sie ist gut geeignet, um Eigenschaften von rekursiv definierten Funktionen zu beweisen.

Vorgehen

[Bearbeiten]Zunächst vermutet man eine Eigenschaft (z.B. Aufwandsklasse einer Rekursionsgleichung). Nun folgt der Induktionsanfang: Eigenschaft hält für ein kleines n. Als nächstes folgt der Induktionsschritt: Die Annahme ist, dass wir es bereits für ein kleineres n gezeigt haben und wenn die Eigenschaft für kleinere n hält, dann hält sie auch für das nächstgrößere n!

Beispiel 1

[Bearbeiten]

Nun wollen wir die obere Grenze für den Aufwand bestimmen. Unsere Vermutung ist, dass . Nun müssen wir zeigen, dass ( siehe Definition der O-Notation). Die vereinfachte Annahme lautet . Hierbei werden keine Spezialfälle behandelt und im Induktionsschritt wird von nach n gegangen.

Induktionsvermutung:

Induktionsschritt: Wir beweisen von

zu zeigende obere Grenze:

Rekursionsgleichung einsetzen:

Induktionsvermutung einsetzen:

Somit ist der Induktionsschritt erfolgreich, wenn .

Induktionsanfang

Wir zeigen die Induktionsvermutung für einen Anfangswert, am einfachsten ist es, dies für den Rekursionsabbruch zu zeigen.

Zu zeigende obere Grenze:

Rekursionsgleichung einsetzen:

Der Induktionsanfang ist erfolgreich, wenn ist. Doch wann können wir zeigen, dass ist? Für den Wert, den wir im Induktionsanfang gezeigt haben, also für und wenn .

Beispiel 2

[Bearbeiten]

Nun wollen wir die obere Grenze für den Aufwand bestimmen. Unsere Vermutung ist, dass . Nun müssen wir zeigen, dass . Die vereinfachte Annahme lautet .

Induktionsvermutung:

Induktionsschritt: Wir beweisen von

Das Problem ist nun, dass wir den Induktionsschritt für positive n zeigen wollen und nicht für negative, daher müssen wir neu ansetzen.

Induktionsvermutung:

Dabei gibt es folgenden Trick: Modifiziere die Induktionsvermutung, in dem ein kleineres Polynom addiert wird.

Induktionsschritt: Wir beweisen von

Induktionsanfang für n=1

Wann können wir nun zeigen, dass ?

Für . Somit haben wir gezeigt, dass

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 7.2.5 zu finden.

Mastertheorem

[Bearbeiten]Auf dieser Seite wird das Master Theorem behandelt. Die Mastermethode ist ein „Kochrezept“ zur Lösung von Rekursionsgleichungen der Form:

mit den Konstanten , f(n) ist eine asymptotische, positive Funktion, d.h.

- a steht dabei für die Anzahl der Unterprobleme.

- n/b ist die Größe eines Unterproblems

- T(n/b) ist der Aufwand zum Lösen eines Unterproblems (der Größe n/b)

- f(n) ist der Aufwand für das Zerlegen und Kombinieren in bzw. von Unterproblemen

Bei der Mastermethode handelt es sich um ein schnelles Lösungsverfahren zur Bestimmung der Laufzeitklasse einer gegebenen rekursiv definierten Funktion. Dabei gibt es 3 gängige Fälle:

- Fall 1: Obere Abschätzung

- Fall 2: Exakte Abschätzung

- Fall 3: Untere Abschätzung

Lässt sich keiner dieser 3 Fälle anwenden, so muss die Komplexität anderweitig bestimmt werden und wir müssen Voraussetzungen für die Anwendung des Mastertheorems überprüfen.

Dafür vergleicht man mit . Wir verstehen n/b als . Im Folgenden verwenden wir die verkürzte Notation .

Fall 1

[Bearbeiten]Wenn . Daraus folgt, dass f(n) polynomiell langsamer wächst als um einen Faktor . Damit haben wir die Lösung .

Fall 2

[Bearbeiten]Wenn . Daraus folgt, dass f(n) und vergleichbar schnell wachsen. Damit haben wir die Lösung .

Fall 3

[Bearbeiten]Wenn und die Regularitätsbedingung für eine Konstante und genügend große n erfüllt. Daraus folgt, dass f(n) polynomiell schneller wächst als um einen Faktor und f(n) erfüllt die sogenannte Regularitätsbedingung. Damit haben wir die Lösung .

Bedeutung

[Bearbeiten]In jedem Fall vergleichen wir f(n) mit . Intuitiv kann man sagen, dass die Lösung durch die größere Funktion bestimmt wird. Im zweiten Fall wachsen sie ungefähr gleich schnell. Im ersten und dritten Fall muss f(n) nicht nur kleiner oder größer als sein, sondern auch polynomiell kleiner oder größer um einen Faktor . Der dritte Fall kann nur angewandt werden, wenn die Regularitätsbedingung erfüllt ist.

Regularitätsbedingung

[Bearbeiten]Doch wozu wird die Regularitätsbedingung benötigt? Zur Erinnerung, im dritten Fall dominiert f(n) das Wachstum von T(n). Wir müssen an dieser Stelle sicherstellen, dass auch bei rekursivem Anwenden, also wenn die Argumente kleiner werden, T(n) von f(n) dominiert wird. Veranschaulicht heißt das:

für Das Wachstum muss durch f(n) dominiert werden und darf f(n) nicht dominieren.

Die Regularitätsbedingung gilt wenn sie für f(n) und g(n) gilt auch für und auch für

Nachweis für

Voraussetzung ist, dass die Regularitätsbedingung für f(n) und g(n) gilt, d.h.:

Für gilt:

man wählt

und

Nachweis für

Voraussetzung ist, dass die Regularitätsbedingung für f(n) und g(n) gilt, d.h.:

Für gilt:

man wählt

und

Überblick

[Bearbeiten]Ist T(n) eine rekursiv definierte Funktion der Form

Dann gilt:

- 1. Fall: Wenn

- 2. Fall: Wenn

- 3. Fall: Wenn und und genügend große n dann

Idee

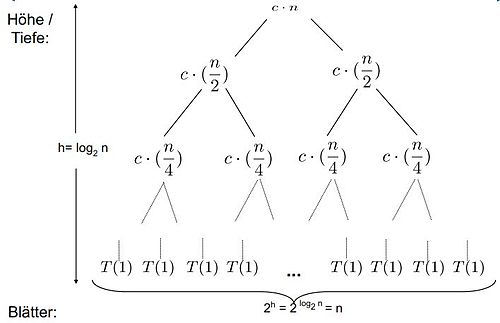

[Bearbeiten]Wir haben folgenden Rekursionsbaum:

Auf der ersten Ebene ist der Aufwand f(n), auf der zweiten Ebene und auf der dritten Ebene . Die Höhe des Baumes beträgt . Die Anzahl der Blätter berechnet sich durch und beträgt somit .

Fall 1: Das Gewicht wächst geometrisch von der Wurzel zu den Blättern. Die Blätter erhalten einen konstanten Anteil des Gesamtgewichts.

Fall 2: k ist 0 und das Gewicht ist ungefähr das Gleiche auf jedem der Ebenen.

Fall 3: Das Gewicht reduziert sich geometrisch von der Wurzel zu den Blättern. Die Wurzel erhält einen konstanten Anteil am Gesamtgewicht.

Beispiel 1

[Bearbeiten]

Fall 1:

Beispiel 2

[Bearbeiten]

Fall 2:

Beispiel 3

[Bearbeiten]

Fall 3:

und (Regularitätsbedingung)

für

Beispiel 4

[Bearbeiten]

Welcher Fall liegt nun vor? Das Mastertheorem kann an dieser Stelle nicht benutzt werden, da

- 1. Fall

- 2. Fall

- 3. Fall

Nützliche Hinweise

[Bearbeiten]- Basisumrechnung

- de L'Hospital

- Vergleiche Logarithmus vs. Polynom

Rekursionsbäume

[Bearbeiten]Auf dieser Seite wird das Thema Rekursionsbäume behandelt. Das allgemeine Problem ist, dass man zum Abschätzen von der Aufwandsklasse einer Rekursionsgleichung gute Vermutungen braucht. Doch wie kommt man darauf? Ein Ansatz ist die Veranschaulichung durch einen Rekursionsbaum. Die Aufwandsklasse wird dann durch die Rekursionsbaummethode bestimmt. Das ist sehr nützlich, um eine Lösung zu raten, die danach durch eine andere Methode (z.B. Induktion) gezeigt wird. Rekursionsbäume sind besonders anschaulich bei Divide-and-Conquer-Algorithmen.

Spezialfall Divide and Conquer

[Bearbeiten]Bei MergeSort sehen die Divide and Conquer Schritte wie folgt aus:

- Divide: Zerteile eine Folge mit n Elementen in zwei Folgen mit je n/2 Elementen.

- Conquer: Wenn die resultierende Folge 1 oder 0 Elemente enthält,dann ist sie sortiert. Ansonsten wende MergeSort rekursiv an.

- Combine: Mische die zwei sortierten Teilfolgen.

public List mergeSort(List f) {

if (f.size() <= 1) {

return f;

} else {

int m = f.size() / 2;

List left = mergeSort(f.subList(0,m));

List right = mergeSort(f.subList(m,f.size());

return merge(left, right);

}

}

Rekursionsbaum

[Bearbeiten]Herleitung des Aufwandes

[Bearbeiten]Die Grundidee ist das wiederholte Einsetzen der Rekursionsgleichung in sich selbst als Baum dargestellt. Das Ziel ist ein Muster zu erkennen. Bei einem Rekursionsbaum beschreibt ein Knoten die Kosten eines Teilproblems. Die Blätter sind die Kosten der Basis fällt T(0) und T(1). Der Aufwand bestimmt sich aus der Summe über alle Ebenen.

1. Ebene

2. Ebene

3. Ebene

....

n. Ebene

Der Aufwand berechnet sich nun wie folgt:

Allgemein bestimmt sich der Aufwand T(n) durch die Summe des Aufwands je Ebene und des Aufwands der Blattebene.

Bezogen auf den gegebenen Rekursionsbaum wäre das

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 8.3 zu finden.

Sortieren

[Bearbeiten]Sortieren Grundlagen

[Bearbeiten]Dieses Kapitel gibt eine grundlegende Einführung in das Thema Sortieren. Sortieren ist ein grundlegendes Problem in der Informatik. Es beinhaltet das Ordnen von Dateien mit Datensätzen, die Schlüssel enthalten und das Umordnen der Datensätze, so, dass eine klar definierte Ordnung der Schlüssel (numerisch/alphabetisch) besteht. Eine Vereinfachung ist die Betrachtung der Schlüssel, z.B. ein Feld von int-Werten.

Ordnung

[Bearbeiten]- Partielle Ordnung

- Sei M eine Menge und binäre Relation.

- Es gilt:

- Reflexivität

- Transitivität

- Antisymmetrie

- Es gilt:

- Strikter Anteil einer Ordnungsrelation

- Totale Ordnung

- Partielle Ordnung

- Trichotomie ("Dreiteilung")

Grundbegriffe

[Bearbeiten]Das Verfahren ist intern, wenn auf Hauptspeicherstruktur, wie Felder und Listen sortiert wird. Hingegen ist es extern, wenn die Datensätze auf externen Medien, wie Festplatten und weitere sortiert werden. Die Annahmen sind eine totale Ordnung, aufsteigend vs. absteigend und der Platzbedarf.

Problembeschreibung

[Bearbeiten]Als Eingabe haben wir eine Folge von Zahlen . Als Ausgabe haben wir die Permutation der Zahlen mit der Eigenschaft . Die Sortierung erfolgt nach einem Schlüssel, z.B. Zahlen. In Programmen ist es übertragbar auf beliebige Datenstrukturen mit Schlüssel.

Stabilität

[Bearbeiten]Ein Sortierverfahren heißt stabil, wenn es die relative Reihenfolge gleicher Schlüssel in der Datei beibehält. Beispiel: alphabetisch geordnete Liste von Personen soll nach Alter sortiert werden. Personen mit gleichem Alter sollen weiterhin alphabetisch geordnet bleiben:

Name Alter Name Alter Aristoteles 24 Aristoteles 24 Platon 28 SORTIEREN → Platon 28 Sokrates 30 Theophrastos 28 Theophrastos 28 Sokrates 30

Sortieralgorithmen

[Bearbeiten]Java Stub

[Bearbeiten]public class InsertionSort extends Sort {

/*

* Sortiert die Sequenz a nach dem Verfahren

* „Sortieren durch Einfügen“

*/

@Override

public void execute(int[] a) {

// Elemente: a[0], … , a[n-1]

int n=a.length;

int x;

int j;

// HIER KOMMT DER SORTIERALGORITHMUS

// assert: a[0] <= … <= a[n-1]

}

}

Vergleichsbasiertes Sortieren

[Bearbeiten]Das vergleichbasierte Sortieren ist ein wichtiger Spezialfall des Sortierproblems. Zur Sortierung können nur direkte Vergleiche zweier Werte benutzt werden. Der Wertebereich der Schlüssel kann beliebig sein. Als Eingabe haben wir ein Array ganzer Zahlen und als Ausgabe ein sortiertes Array mit den selben Zahlen mit erhaltenen Mehrfachvorkommen. Einige Sortierverfahren sind effizienter, wenn Listen anstatt Arrays benutzt werden.

Sortierinterface in Java

[Bearbeiten]public interface Sort {

/**

* sorts the given array.

* @param toSort - array to sort.

*/

public void execute(int[] toSort);

}

Ausblick

[Bearbeiten]Auf den folgenden Seiten werden die Sortieralgorithmen Insertion Sort, Selection Sort, Merge Sort und Quick Sort behandelt.

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.2 zu finden.

InsertionSort

[Bearbeiten]Dieses Kapitel behandelt die Sortiermethode InsertionSort oder auch Sortieren durch Einfügen genannt. Die Idee des Algorithmus ist, die typische menschliche Vorgehensweise, etwa beim Sortieren eines Stapels von Karten umzusetzen. Das heißt es wird mit der ersten Karte ein neuer Stapel gestartet. Anschließend nimmt man jeweils die nächste Karte des Originalstapels und fügt diese an der richtigen Stelle im neuen Stapel ein.

Beispiel

[Bearbeiten]Java Code

[Bearbeiten]void InsertionSort(int[] F) {

int m,j;

for (int i = 1; i < F.length; i++){

j = i;

m = F[i];

while (j > 0 && F[j-1] > m) {

/*verschiebe F[j-1] nach rechts */

F[j] = F[j-1];

j--;

}

F[j] = m;

}

}

Das Array hat F.length viele Elemente von Position 0 bis F.Length-1. Wenn F[j-1] größer m ist, dann wird F[j-1] nach rechts verschoben. Am Ende des Algorithmus wird F[i] an Position F[j] gesetzt.

Analyse

[Bearbeiten]Theorem der Terminierung

[Bearbeiten]Das Theorem der Terminierung besagt, dass der Algorithmus InsertionSort für jede Eingabe int[] F nach endlicher Zeit terminiert.

Beweis

[Bearbeiten]Die Laufvariable i in der äußeren for‐Schleife wird in jedem Durchgang um eins erhöht und wird damit irgendwann die Abbruchbedingung (eine Konstante)erreichen. Die Laufvariable j der inneren while‐Schleife wird in jedem Durchgang um eins verringert und somit die Schleifenbedingung j>0 irgendwann nicht mehr erfüllen.

Theorem der Korrektheit

[Bearbeiten]Das Theorem der Korrektheit besagt, dass der Algorithmus InsertionSort das Problem des vergleichsbasierten Sortierens löst. Beweisen

Beweis

[Bearbeiten]Wir zeigen, dass die folgende Aussage eine Invariante der äußeren for‐Schleife ist (d.h. sie ist am Ende eines jeden Schleifendurchgangs gültig): Das Teilarray F[0..i] ist sortiert Damit gilt auch, dass nach Abbruch der for‐Schleife das Array F[0..n]=F (mit n=F.length‐1) sortiert ist. Zu zeigen ist nun, dass am Ende jeden Durchgangs der äußeren for Schleife F[0...i] sortiert ist. Dies wird durch Induktion nach i gezeigt. Für i=1 gilt im ersten Durchgang wird das erste Element F[0] mit dem zweiten Element F[1] verglichen und ggfs. getauscht um Sortierung zu erreichen (while‐Bedingung). Für gilt angenommen F[0...i] ist am Anfang der äußeren for‐Schleife im Durchgang i+1 sortiert. In der while‐Schleife werden Elemente solange einen Platz weiter nach hinten verschoben, bis ein Index k erreicht wird, sodass alle Elemente mit Index 0..k‐1 kleiner/gleich dem ursprünglichen Element an Index i+1 sind (Induktionsbedingung) und alle Elemente mit Index k+1...i+1 größer sind (while‐Bedingung). Das ursprüngliche Element an Index i+1 wird dann an Position k geschrieben. Damit gilt, dass F[0...i+1] sortiert ist.

Theorem der Laufzeit

[Bearbeiten]Das Theorem der Laufzeit besagt, dass die Anzahl der Vergleichsoperationen von Insertion Sort im besten Fall ist und im durchschnittlichen und schlechtesten .

Beweis

[Bearbeiten]Für die Aufwandsanalyse sind die Anzahl der Vertauschungen und der Vergleiche relevant. Allerdings dominieren die Vergleiche die Vertauschungen, das heißt es werden wesentlich mehr Vergleiche als Vertauschungen benötigt. Wir müssen in jedem Fall alle Elemente i:=1 bis n-1 durchgehen, d.h. immer Faktor n-1 für die Anzahl der Vergleiche. Dann müssen wir zur korrekten Einfügeposition zurückgehen

Im besten Fall ist die Liste schon sortiert. Die Einfügeposition ist gleich nach einem Schritt an Position i-1, d.h. die Anzahl der Vergleiche ist gleich der Anzahl der Schleifendurchläufe = n-1. Bei jedem Rückweg zur Einfügeposition nimmt man den Faktor 1. Somit beträgt die Gesamtzahl der Vergleiche: . Für große Listen lässt sich abschätzen. Damit haben wir einen linearen Aufwand.

Im mittleren Fall ist die Liste unsortiert. Die Einfügeposition befindet sich wahrscheinlich auf der Hälfte des Rückwegs. Bei jedem der n-1 Rückwege, muss ein (i-1)/2 Vergleich addiert werden. Die Gesamtzahl der Vergleiche beträgt dann:

Daraus ergibt sich ein quadratischer Aufwand, wenn konstante Faktoren nicht berücksichtigt werden.

Im schlechtesten Fall ist die Liste absteigend sortiert. Die Einfügeposition befindet sich am Ende des Rückgabewertes bei Position 1. Bei jedem der n-1 Rückwege müssen i-1 Elemente verglichen werden (d.h. alle vorherigen Elemente F[1...i-1]). Analog zu vorhergehenden Überlegungen, gibt es hier aber die doppelte Rückweglänge. Daraus ergibt sich die Gesamtanzahl der Vergleiche:

Daraus ergibt sich ein quadratischer Aufwand, wenn konstante Faktoren nicht berücksichtigt werden.

Optimierung

[Bearbeiten]In der vorgestellten Version des Algorithmus wird die Einfügeposition eines Elements durch (umgekehrte) sequenzielle Suche gefunden. Verwendet man hier binäre Suche (das Teilarray vor dem aktuellen Element ist sortiert!) kann die Anzahl der Vergleichsoperationen gesenkt werden zu O(n log n) (genauere Analyse zeigt, dass die Zahl noch kleiner ist)

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.2.2 zu finden.

SelectionSort

[Bearbeiten]Dieses Kapitel behandelt die Suchmethode SelectionSort. Die Idee dieses Suchalgorithmus ist, den jeweils größten Wert im Array zu suchen und diesen an die letzte Stelle zu tauschen. Anschließend fährt man mit der um 1 kleineren Liste fort.

Beispiel

[Bearbeiten]Java Code

[Bearbeiten]void SelectionSort(int[] F) {

int marker = F.length -1;

while (marker >= 0) {

/*bestimme größtes Element links v. Marker*/

int max = 0; /* Indexposition*/

for (int i = 1; i <= marker; i++){

if (F[i] > F[max])

max = i;

swap(F, marker, max);

marker--; /*verkleinere Array */

}

void swap(int[] F, int idx1, int idx2) {

int tmp = F[idx1];

F[idx1] = F[idx2];

F[idx2] = tmp;

}

In Java benutzt man die Hilfsmethode swap, welche zwei Elemente im Array vertauscht.

Analyse

[Bearbeiten]Theorem der Terminierung

[Bearbeiten]Das Theorem der Terminierung besagt, dass der Algorithmus SelectionSort für jede Eingabe int[]F nach endlicher Zeit terminiert.

Beweis

[Bearbeiten]Die Variable marker wird zu Anfang des Algorithmus auf einen positiven endlichen Wert gesetzt und in jedem Durchgang der äußeren while‐Schleife um 1 verkleinert. Abbruch der while Schleife erfolgt, wenn marker kleiner 0 ist, also wird die while‐Schleife endlich of durchlaufen. Die innere for‐Schleife hat in jedem Durchgang marker‐viele (also endlich viele) Durchläufe.

Theorem der Korrektheit

[Bearbeiten]Das Theorem der Korrektheit besagt, dass der Algorithmus SelectionSort das Problem des vergleichsbasierten Sortierens löst.

Beweis

[Bearbeiten]Es gilt zunächst, dass die innere for‐Schleife stets den Index des Maximums des Teilarrays F[0...marker] berechnet und in max speichert. Weiterhin gilt, dass die Methode swap(F, marker, max) die Werte F[marker] und F[max] vertauscht.

Wir zeigen nun, dass die folgenden Aussagen Invariante der äußeren while-Schleife ist (d.h. sie sind am Ende eines jeden Schleifendurchgangs gültig):

- ) Das Teilarray F[marker+1...n] ist sortiert

- ) Alle Zahlen in F[0...marker] sind nicht größer als jede Zahl in F[marker+1...n]

Damit gilt (nach 1.) auch, dass nach Abbruch der while‐Schleife das Array F[0..n]=F (mit n=F.length‐1) sortiert ist.

Zeige dies durch Induktion nach i=n‐marker:

- i=1: Im ersten Durchgang wird das Maximum as F[0..n] bestimmt und an die letzte Stelle F[n] vertauscht. Damit gilt sowohl 1.) als auch 2.)

- i→i+1: Nehme an, dass nach dem i‐ten Durchgang der while‐Schleife gilt

- ) Das Teilarray F[(i‐n+1)...n] ist sortiert

- ) Alle Zahlen in F[0...(i‐n)] sind nicht größer als jede Zahl in F[(i‐n+1)...n]

Im (i+1) Durchgang wird zunächst das Maximum aus F[0...(i‐n)] bestimmt und anschließend mit dem Element an Position F[i‐n] getauscht. Da nach 2.) dieses Element nicht größer war als jede Zahl in F[(i‐n+1)...n], ist nun F[(i‐n)...n] sortiert (Invariante 1.). Da wir aus F[0...(i‐n)] ein Maximum genommen haben, kann nun auch kein Element in F[0...(i‐n‐1)] größer sein, als jede Zahl in F[(i‐n)...n] (Invariante 2.)

Theorem der Laufzeit

[Bearbeiten]Das Theorem der Laufzeit besagt, dass der Algorithmus SelectionSort eine Laufzeit von hat im besten, mittleren und schlechtesten Fall.

Beweis

[Bearbeiten]Die äußere while‐Schleife wird genau n‐mal (n=F.length) durchlaufen. Dort werden somit n Vertauschungen vorgenommen (=jeweils konstanter Aufwand). Die innere for‐Schleife hat im i‐ten Durchlauf der while‐Schleife n‐i Durchläufe mit jeweils einem Vergleich, deswegen insgesamt

Die Anzahl der Vergleiche ist im besten, mittleren und schlechteste Fall identisch, da immer das komplette Array durchlaufen wird.

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.2.3 zu finden.

BubbleSort

[Bearbeiten]Dieses Kapitel behandelt die Suchmethode BubbleSort. Es handelt sich hierbei um ein sehr bekanntes, aber nicht besonders effizientes Sortierverfahren. Es ist eine einfach zu implementierende zugrunde liegende Vorstellung. Bei einer vertikalen Anordnung von Elementen in Form von Luftblasen (bubbles) werden wie in einer Flüssigkeit von alleine sortiert, da die größeren Blasen die kleiner „überholen“. Das Grundprinzip ist somit die Folge immer wieder zu durchlaufen und dabei benachbarte Elemente, die nicht die gewünschte Sortierreihenfolge haben, zu vertauschen. Das bedeutet Elemente die größer sind als ihre Nachfolger, überholen diese.

Beispiel

[Bearbeiten]Java Code

[Bearbeiten]void BubbleSort(int[] F) {

for (int n= F.length; n >1; n=n-1) {

for (int i =0; i < F.length-1; i++) {

if (F[i] > F[i+1]){

swap(F, i, i+1);

}

}

}

}

Hierbei handelt es sich um die einfachste Form, doch der Algorithmus kann auch optimiert werden. Wir haben beobachtet, dass die größte Zahl in jedem Durchlauf automatisch an das Ende der Liste rutscht. Daraus folgt in jedem Durchlauf j reicht die Untersuchung bis Position n-j, das heißt im j.ten Durchlauf sind die Elemente zwischen den Positionen n-j und n-1 sortiert. Wenn keine Vertauschung mehr stattfindet, soll das Programm abbrechen.

void BubbleSort(int[] F) {

boolean swapped;

int n = F.length;

do {

swapped = false;

for (int i =0; i < n-1; i++) {

if (F[i] > F[i+1]){

swap(F, i, i+1);

swapped = true;

}

}

n--;

}while (swapped);

}

Aufwand

[Bearbeiten]Im besten Fall beträgt der Aufwand n. Im mittleren Fall ohne Optimierung und mit Optimierung . Im schlechtesten Fall ohne Optimierung beträgt der Aufwand und mit Optimierung .

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.2.4 zu finden.

MergeSort

[Bearbeiten]In diesem Kapitel wird der Sortieralgorithmus MergeSort behandelt.

Rückblick

[Bearbeiten]Die bisherige Verfahren erforderten einen direkten Zugriff auf einzelne Elemente (z.B. in einem Array). Sie sind besonders geeignet für internes Sortieren. Allerdings gibt es Probleme, wenn Daten sortiert werden sollen, die nicht in den den Hauptspeicher passen. Daher brauchen wir andere Verfahren, die nicht zwingend Elemente intern verwalten. Das Prinzip dieser Algorithmen ist das Sortieren in mehreren Phasen oder Schritten.

Idee

[Bearbeiten]MergeSort ist ein Divide-and-Conquer Algorithmus zum vergleichsbasierten Sortieren. Zuerst wird die zu sortierende Folge in zwei Teile geteilt. Anschließend werden beide Teile voneinander getrennt sortiert. Zuletzt werden beide Teilergebnisse in der richtigen Reihenfolge zusammen gemischt.

Beispiel

[Bearbeiten]Algorithmus

[Bearbeiten]void mergeSort(int[] F) {

int[] tmpF = new int[F.length];

mergeSort(F, tmpF, 0, F.length -1);

}

void mergeSort(int[] F, int[] tmpF, int left,int right)

{

if (left < right) {

int m = (left + right)/2;

mergeSort(F, tmpF, left, m);

mergeSort(F, tmpF, m+1, right);

merge(F, tmpF, left, m+1, right);

}

}

void merge(int[] F, int[] tmpF, int startLeft, int startRight, int endRight) {

int endLeft = startRight-1;

int tmpPos = startLeft;

int numElements = endRight – startLeft +1;

while (startLeft <= endLeft && startRight <= endRight)

if (F[startLeft] < F[startRight])

tmpF[tmpPos++] = F[startLeft++];

else

tmpF[tmpPos++] = F[startRight++];

while (startLeft <= endLeft)

tmpF[tmpPos++] = F[startLeft++];

while (startRight <= endRight)

tmpF[tmpPos++] = F[startRight++];

for (int i = 0; i < numElements; i++, endRight--)

F[endRight] = tmpF[endRight];

}

Das Abbruchkriterium für den rekursiven Aufruf ist eine einelementige Liste.Der Misch-Vorgang erfordert in der Regel doppelten Speicherplatz, da eine neue Folge aus den beiden Sortierten generiert werden muss. Eine Alternative ist das Mischen in einem Feld (in-place), das erfordert aber aufwendiges Verschieben.

Analyse

[Bearbeiten]Theorem der Terminierung

[Bearbeiten]Das Theorem der Terminierung besagt, dass der Algorithmus MergeSort für jeden Eingabe int[]F nach endlicher Zeit terminiert.

Beweis

[Bearbeiten]Zeige zunächst, dass jeder Aufruf mergeSort(int[] F, int[] tmpF, int left,int right) terminiert:

- Falls lef < right nicht gilt, terminiert der Aufruf sofort

- Andernfalls rufen wir mergeSort rekursiv auf, wobei entweder lef einen echt größeren oder right einen echt kleineren Wert erhält. In jedem Fall wird nach einem gewissen rekursiven

Abstieg irgendwann lef<right nicht mehr gelten.

Theorem der Korrektheit

[Bearbeiten]Das Theorem der Korrektheit besagt, dass der Algorithmus MergeSort das Problem des vergleichsbasierten Sortierens löst.

Beweis

[Bearbeiten]Durch Induktion nach n = F.length. Annahme n=2 für eine ganze Zahl k.

- n=1: Für n=1 ist der erste Aufruf der mergeSort Hilfsmethode mergeSort(F, tmpF, 0, 0)

und somit gilt nicht lef < right. Die Methode terminiert ohne Änderung an F. Dies ist korrekt, da jedes einelementige Array sortiert ist.

- n/2 → n: Sei F[0...n‐1] ein beliebiges Array. Der erste Aufruf mergeSort(F, tmpF, 0, n-1) erfüllt lef<right und es werden folgende Rekursive Aufrufe getätigt: mergeSort(F, tmpF, 0, n/2-1) mergeSort(F, tmpF, n/2, n-1) Beide Aufrufe erhalten ein Array der Länge n/2. Nach Induktionsannahme gilt, dass anschliessend sowohl F[0...n/2‐1] als auch F[n/2...n‐1] separat sortiert sind. Noch zu zeigen ist, dass merge korrekt zwei sortierte Arrays in ein sortiertes Array mischt.

Theorem der Laufzeit

[Bearbeiten]Das Theorem der Laufzeit besagt, dass der Algorithmus MergeSort eine Laufzeit von hat. Diese Laufzeit ist die selbe für den besten, mittleren und schlechtesten Fall.

Beweis

[Bearbeiten]

Nun wenden wir das Master Theorem an.

Im 2. Fall, wenn

Hier ist a=2 und b=2 und es folgt

Es ist zudem f(n)=n und es gilt für k=0:

Es folgt

Literatur

[Bearbeiten]Da die Vorlesungsinhalte auf dem Buch Algorithmen und Datenstrukturen: Eine Einführung mit Java von Gunter Saake und Kai-Uwe Sattler aufbauen, empfiehlt sich dieses Buch um das hier vorgestellte Wissen zu vertiefen. Die auf dieser Seite behandelten Inhalte sind in Kapitel 5.2.5 zu finden.

Zwischenbemerkungen

[Bearbeiten]An dieser Stelle gibt es einige Zwischenbemerkungen zu den vorgestellten Sortieralgorithmen.

Einordnung der elementaren Sortierverfahren

[Bearbeiten]| Implementierung Array | Implementierung Liste | |

| greedy | selection sort, bubble sort | insertion sort |

| divide-and-conquer | quicksort | merge sort |

Eigenschaften

[Bearbeiten]Divide and conquer bedeutet teile und herrsche. Dabei wird das eigentliche Problem so lange in kleiner und einfachere Teilprobleme zerlegt, bis man diese lösen kann.Oft können Teilprobleme parallel gelöst werden. Des weiteren sind Teilprobleme „eigenständige“ Probleme. Anschließend werden die Teillösungen zu einer Gesamtlösung zusammengeführt.

Greedy bedeutet gierig. Hierbei wird schrittweise ein Folgezustand ausgewählt, der aktuell den größten Gewinn und das beste Ergebnis verspricht. Die Auswahl des Folgezustands erfolgt anhand von Bewertungsfunktionen und Gewichtsfunktionen. Ein Problem dabei ist, dass oft nur ein lokales Maximum gewählt wird. Mehr dazu im Thema Entwurfsmuster.

Generische Implementierung

[Bearbeiten]Algorithmen werden „parametrisiert“ durch Vergleichsoperator. Im Paket java.lang gibt es dafür ein Interface Comparable. Der Aufruf der Vergleichsmethode a.compareTo(b) liefert ein Zahl <0, =0, >0 für a<b, a=b und a größer b. Das Muster für Objekte vom Referenztyp Comparable lautet:

public class MyObject implements Comparable {

MyType data;

public int compareTo (MyObject obj) {

if („this.data < obj.data“) return -1;

if („this.data = obj.data“) return 0;

if („this.data > obj.data“) return 1;

}

}

Das Muster für Aufrufe in Klassenmethoden bei Suchverfahren lautet:

public static int binarySearch( Comparable[] f,

Comparable a, int l, int r) {

int p = (l+r)/2;

int c = f[p].compareTo(a);

... }

Listenimplementierung generisch

[Bearbeiten]

public class MyObject implements Comparable {. . .}

public class Node {

MyObject data;

Node next;

}

public class OrderedList {

private Node head;

public OrderedList sort ( ) {. . .}

Interne Hilfsmethoden

[Bearbeiten]- int findMin(){...}

- F.findMin() bestimmt den Index des minimalen Elements von OrderedList F

- void insertLast(int a)

- F.insertLast(a) fügt Element mit Index (Key) a an das Ende von F an

- void deleteElem(int a)

- F.deleteElem(a) löscht Element mit Index a aus der Liste F

- Aufwand: jeweils = O(n), wenn n = Anzahl der Objekte in Liste

MergeSort generisch

[Bearbeiten]

public class OrderedList {

OrderedNode head;

int length;

// ...

/** * Sorts this list in non-descending order */

public void mergeSort() {

OrderedList aList, bList; // the divided lists

OrderedNode aChain; // start of first node chain

OrderedNode bChain; // start of second node chain

OrderedNode tmp; // working node for split

// trivial cases

if ( (head==null) || (head.next == null) )

return;

// divide: split the list in two parts

aChain = head;

tmp = head; // init working node for split

// advance half of the list

for (int i=0; i < (length-1) / 2; i++)

tmp=tmp.next;

// cut chain into aChain and bChain

bChain=tmp.next;

tmp.next=null;

// encapsulate the two node chains in two lists

aList = new OrderedList();

aList.head=aChain;

aList.length=length/2;

bList = new OrderedList();

bList.head=bChain;

bList.length=length - aList.length;

// conquer: recursion

aList.mergeSort(); bList.mergeSort();

// join: merge

merge(aList, bList);

}

}

Aus Gründen der Übersichtlichkeit erzeugt dieses Programm im Divide-Schritt jeweils gekapselte Zwischenlisten vom Typ OrderedList. In der Praxis würde man hierauf verzichten und rein auf Knoten-Ketten arbeiten, da insgesamt O(n) Objekte vom Typ OrderedList erzeugt und wieder vernichtet werden(maximal O(log n) davon sind gleichzeitig aktiv).

QuickSort

[Bearbeiten]In diesem Kapitel wird der Sortieralgorithmus QuickSort behandelt.

Idee

[Bearbeiten]Es gibt eine rekursive Aufteilung (wie bei MergeSort), aber hier werden Mischvorgänge vermieden (speicherintensiv!). Die Teillisten werden in zwei Hälften geteilt bezüglich eines Pivot-Elements, wobei in einer Liste alle Elemente größer als das PivotElement sind und in der anderen Liste alle kleiner. Das Pivot Element ist ein beliebiges Element der Liste/Folge, z.B. das linke, mittlere oder rechte Element.

Beispiel

[Bearbeiten]Vertauschen von Elementen

[Bearbeiten]Für gegebenes Pivot-Element p wird die Folge von links durchsuchen, bis das Element gefunden wurde, das größer oder gleich p ist. Und gleichzeitig wird die Folge von rechts durchsuchen, bis das Element gefunden ist, das kleiner p ist. Dabei werden die Elemente ggf. getauscht.

Sortierprinzip

[Bearbeiten]Sortieren einer Folge F[u...o] nach dem „divide-and-conquer“Prinzip. Divide heißt die Folge F[u...o] wird in zwei Teilfolgen F[u...p-1] und F[p+1...o] geteilt. Die zwei Teilfolgen haben folgende Eigenschaften:

- F[i] ≤ F[p] für alle i = u,...,p-1

- F[i] > F[p] für alle i = p+1, …, o

Conquer bedeutet, dass die Teilfolgen sortiert werden. Mit combine werden die Teilfolgen zu F[u...o] verbunden. Vergleiche sind an dieser Stelle nicht erforderlich, da die Teilfolgen bereits sortiert sind.

Pivot Element

[Bearbeiten]Im Prinzip muss man nicht das letzte Element als Pivot‐Element wählen. Je nach Verteilung der Daten, kann es sinnvoll sein ein anderes Element zu wählen. Wenn beispielsweise die Liste schon fast sortiert ist, sollte man immer das mittlere Element wählen Eine optimale Rekursion erhält man, wenn man immer den Median als Pivot-Element wählt (dieser ist aber nicht direkt bestimmbar, dafür müsste man die Liste erst sortiert haben. Hat man ein Pivot-Element ausgewählt, tauscht man dies einfach mit dem letzten Element und benutzt den Algorithmus wie zuvor.

Algorithmus

[Bearbeiten]void quickSort(int[] F, int u, int o) {

if (u < o) {

int p = (u+o)/2;

int pn = zerlege(F,u,o,p);

quickSort(F,u,pn-1);

quickSort(F,pn+1,o);

}

int zerlege(int[] F, int u, int o, int p) {

int pivot = F[p];

int i = u;

int j = o;

while (i < j) {

while (F[i] < pivot)

i++;

while (F[j] > pivot)

j--;

if (i < j) {

swap(F,i , j );

}

}

return i;

}

int zerlege(int[] F, int u, int o, int p) {

int pivot = F[p];

//Tausche Pivot-Element mit dem letzten Element

//kann entfallen, wenn immer p=o gewählt wird

swap(F,p, o);

int pn = u;

//bringe kleinere Elemente nach vorne und größere nach hinten

for (int j = u; j < o; j++) {

if (F[j] <= pivot){

swap(F,pn, j );

pn++;

}

}

//bringe das Pivot-Element an die richtige Position und gebe diese zurück

swap(F,pn, o);

return pn;

}

void swap(int[] f, int x, int y){ //Hilfsmethode zum Vertaucshen

int tmp = f[x];

f[x] = f[y];

f[y] = tmp;

}

}

P gibt an ,an welcher Position das Pivot Element ist. Bei diesem Beispiel ist es in der Mitte. Es kann aber auch an Stelle o oder u sein.

Beispiel 1

[Bearbeiten]Zerlege (F,0,6,3) mit 3=(0+6)/2

| 8 | 2 | 1 | 5 | 9 | 7 | 3 |

...

| 3 | 2 | 1 | 5 | 9 | 7 | 3 |

Beispiel 2

[Bearbeiten]Sei f[8]=5 das Pivot-Element

| 8 | 9 | 2 | 6 | 7 | 3 | 4 | 1 | 5 |

Suche von links aus das Element, welches kleiner als das Pivot-Element ist

| 8 | 9 | 2 | 6 | 7 | 3 | 4 | 1 | 5 |

Vertausche mit dem ersten größeren Element

| 2 | 9 | 8 | 6 | 7 | 3 | 4 | 1 | 5 |

Suche das nächste kleinere Element als die 5

| 2 | 9 | 8 | 6 | 7 | 3 | 4 | 1 | 5 |

Vertausche dieses mit dem zweiten größeren Element

| 2 | 3 | 8 | 6 | 7 | 9 | 4 | 1 | 5 |

Suche wieder das nächste kleinere Element

| 2 | 3 | 8 | 6 | 7 | 9 | 4 | 1 | 5 |

und vertausche dies mit dem dritt größeren Element

| 2 | 3 | 4 | 6 | 7 | 9 | 8 | 1 | 5 |

| 2 | 3 | 4 | 6 | 7 | 9 | 8 | 1 | 5 |

| 2 | 3 | 4 | 1 | 7 | 9 | 8 | 6 | 5 |

nun ist man rechts angekommen und hier wird nun das Pivot-Element getauscht

| 2 | 3 | 4 | 1 | 5 | 9 | 8 | 6 | 7 |

Von nun an steht das Pivot-Element an seiner finalen Position. Alle Elemente links vom Pivot-Element sind kleiner und alle auf der rechten Seite sind größer. Das bedeutet, dass nun ein rekursiver Abstieg für die Folgen

| 2 | 3 | 4 | 1 |

und

| 9 | 8 | 6 | 7 |

beginnen würde. Wenn das letzte Element wieder als Pivot-Element gewählt werden würde, dann hat die erste erste Folge nun das Pivot-Element 1 und in der zweiten Folge währe es das Element 7.

Alternative: Zerlegung mit while-schleifen

[Bearbeiten]Man wählt zuerst ein Pivotelement, beispielsweise das mittlere Element. Nun beginnt man von unten an und vergleicht die Einträge mit dem Pivot. Danach beginnt man von oben und vergleicht die Elemente mit dem Pivot. Wenn ein Element kleiner bzw. größer ist als das Pivot Element, dann wird dieses Element getauscht.

Analyse

[Bearbeiten]Theorem der Terminierung

[Bearbeiten]Das Theorem der Terminierung besagt, dass der Algorithmus quickSort für jede Eingabe int[]F nach endlicher Zeit terminiert.

Beweis

[Bearbeiten]In jedem rekursiven Aufruf von quickSort ist die Eingabelänge um mindestens 1 kleiner als vorher und die Rekursionsanfang ist erreicht wenn die Länge gleich 1 ist. In der Methode split gibt es nur eine for‐Schleife, dessen Zähler j in jedem Durchgang inkrementiert wird. Da u<o wird die for‐Schleife also nur endlich oft durchlaufen.

Theorem der Korrektheit

[Bearbeiten]Das Theorem der Korrektheit besagt, dass der Algorithmus quickSort das Problem des vergleichsbasierten Sortierend löst.

Beweis

[Bearbeiten]Die Korrektheit der Methode swap ist zunächst offensichtlich. Zeige nun, dass nach Aufruf pn=split(f,u,o,p) für u<o und gilt:

- f[p] wurde zu f[pn] verschoben

Dies ist klar (vorletzte Zeile der Methode split)

- f[i] ≤ f[pn] für i=u,...,pn‐1

pn wird zu anfangs mit u initialisiert und immer dann inkrementiert, wenn die Position f[pn] durch ein Element, das kleiner/gleich dem Pivot‐Element ist, belegt wird.

- f[i] > f[pn] für i=pn+1,...,o

Folgt aus der Beobachtung, dass in 2.) immer „genau dann“gilt. Beachte zudem, dass Element immer getauscht werden, also die Elemente im Array stets dieselben bleiben.

Die Korrektheit der Methode quickSort folgt nach Induktion nach der Länge von f (n=f.length):

- n=1: Der Algorithmus terminiert sofort und ein einelementiges Array ist stets sortiert

- n→n+1: Nach Korrektheit von split steht das Pivot‐Element an der richtigen Stelle und links und rechts stehen jeweils nur kleinere/größere Element. Die beiden rekursiven Aufrufe von quickSort erhalten jeweils ein Array, das echt kleiner als n+1 ist (mindestens das Pivot‐Element ist nicht mehr Teil des übergebenen Arrays). Nach Induktionsannahme folgt die Korrektheit von quickSort.

Theorem der Laufzeit

[Bearbeiten]Das Theorem der Laufzeit besagt, dass wenn als Pivot Element stets der Median des aktuell betrachteten Arrays gewählt wird, so hat der Algorithmus quickSort eine Laufzeit von .

Beweis

[Bearbeiten]Es gilt zunächst, dass split . Ausschlaggebend ist hier die for-Schleife, die genau n-mal durchlaufen wird. Gilt nach dem Aufruf von split stets pn=(u+o)/2 (dies ist gleichbedeutend damit, dass das Pivot‐Element stets der Median ist), so erhalten wir folgende Rekursionsgleichung für quickSort:

Die ist fast dieselbe Rekursionsgleichung wie für MergeSort und es folgt

Doch was ist, wenn die Voraussetzung des Theorems nicht erfüllt ist und wir ungleiche Rekursionsaufrufe haben?

Theorem der Laufzeit 2

[Bearbeiten]Das Theorem der Laufzeit besagt, dass der Algorithmus quickSort im schlechtesten Fall eine Laufzeit von hat.

Beweis

[Bearbeiten]Angenommen, die Aufteilung erzeugt ein Teilarray mit Länge n‐1 und ein Teilarray mit Länge 0 (Pivot‐Element ist also immer Minimum oder Maximum), dann erhalten wir folgende Rekursionsgleichung für die Laufzeit:

Durch Induktionsbeweis kann leicht gezeigt werden, dass . Dies ist auch tatsächlich der schlechteste Fall.

Für den mittleren Fall kann gezeigt werden, dass quickSort einen Aufwand von hat (wie im besten Fall), die in versteckten Konstanten sind nur etwas größer.

Bemerkung

[Bearbeiten]Im Gegensatz zu MergeSort ist QuickSort durch die Vorgehensweise bei Vertauschungen instabil, d.h. relative Reihenfolge gleicher Schlüssel werden nicht notwendigerweise beibehalten.

Literatur