Kurs:Statistik für Anwender/Darstellung und Korrelation für mehrere Merkmale

Darstellung und Korrelation für (zwei) mehrere Merkmale

[Bearbeiten]In diesem Abschnitt betrachten wir stets zwei Merkmale und auf derselben Grundgesamtheit (man spricht dann von verbundenen Merkmalen). Oft stellt sich die Frage, ob die Merkmale voneinander abhängig sind, das heißt, ob gewisse Werte für mit gewissen anderen Werte für mehr bzw. weniger gehäuft auftreten. Wir wollen nun einige (gemeinsame) Darstellungsformen für zwei verbundene Merkmale angeben und Methoden behandeln, mit denen man ihre Abhängigkeit untersuchen kann.

Verbundene Merkmale

[Bearbeiten]Ist eine Grundgesamtheit und sind und verbundene Merkmale, so bezeichnet man die Abbildung

als zweidimensionales Merkmal. Ein Wertepaar heißt Beobachtungswert.

Beispiel verbundene Merkmale

[Bearbeiten]- Gibt die Größe und das Gewicht einer Person an, so wird man erwarten, dass bei einem hohen Wert auch eher ein hoher Wert für auftritt.

- Ist die Regenmenge (für bestimmte Tage im Sommer) und die Durchschnittstemperatur, so lässt sich (vermutlich) ein umgekehrter Zusammenhang erwarten (eine hohe Regenmenge entspricht eher einer niedrigen Temperatur).

- Falls die Größe einer Person und die Punktzahl in einer Mathematik-Klausur beschreibt, so erwartet man, dass die Beobachtungswerte unabhängig voneinander sind (von Zufälligigkeiten abgesehen).

Urliste

[Bearbeiten]Als Urliste bezeichnet man die Tabelle

beziehungsweise die Auflistung aller Paare von Beobachtungswerten

als Urliste.

Wir schreiben im Folgenden auch kurz und .

Beispiel Urliste bei verbundenem Merkmal

[Bearbeiten]Auf einem Bauernhof werden Hühnereier in Güteklassen (A,B und C) und Gewichtsklassen (S,M,L,XL) eingeteilt. Eine Serie von Eiern wird diesbezüglich statistisch erfasst. Auf der Grundgesamtheit haben wir also die Merkmale Die Urliste könnte nun wie folgt aussehen:

Kontingenztabellen

[Bearbeiten]Gemeinsame absolute und relative Häufigkeit

[Bearbeiten]Sind verbundene Merkmale auf einer Grundgesamtheit mit den Merkmalsräumen (für ) und (für ), so kann man wie zuvor auch die absoluten und relativen Häufigkeiten der beiden einzelnen Merkmale erfassen. An ihnen kann man aber keine Abhängigkeiten der beiden Merkmale feststellen. Man betrachtet daher die gemeinsamen absoluten bzw. relativen Häufigkeiten. Für und bezeichnet man

als absolute Häufigkeit von und

als relative Häufigkeit von .

Kontingenztabelle

[Bearbeiten]Die Tabellen mit diesen Werten

heißen Kontingenztabellen (oder Kreuztabellen).

Beispiel Kontingenztabelle

[Bearbeiten]Im Beispiel Urliste bei verbundenem Merkmal könnten diese Tabellen beispielsweise so aussehen:

Anmerkungen Kontingenztabelle I

[Bearbeiten]- Summiert man zu einem festen die absoluten/relativen Häufigkeiten , so erhält man die absolute/relative Häufigkeit der Merkmalsausprägung für das Merkmal , es gilt also

Analog gilt

Anmerkungen Kontingenztabelle II

[Bearbeiten]- Es gilt

- Kontinenztabellen eignen sich besonders für qualitative Merkmale. Gibt es viele mögliche Merkmalsausprägungen, so kann man diese in Klassen einteilen und dann eine Kontingenztabelle mit den Klassenhäufigkeiten erstellen.

Bedingte relative Häufigkeiten und Unabhängigkeit

[Bearbeiten]Bedingte relative Häufigkeiten

[Bearbeiten]Sind verbundene Merkmale auf einer Grundgesamtheit mit den Merkmalsräumen und , so heißt

bedingte relative Häufigkeit von unter der Bedingung . Analog heißt

bedingte relative Häufigkeit von unter der Bedingung

Beispiel bedingte relative Häufigkeiten

[Bearbeiten]Im Beispiel Urliste bei verbundenem Merkmal ist:

Der Anteil der Eier vom Gewicht S ist unter den Eiern der Güte A kleiner (als insgesamt).

Der Anteil der Eier der Güte C ist unter den Eiern vom Gewicht L größer (als insgesamt).

Der Anteil der Eier der Güte A ist unter den Eiern vom Gewicht XL größer (als insgesamt).

Unabhängigkeit

[Bearbeiten]Man nennt nun zwei Merkmale unabhängig voneinander, falls für alle Merkmalsausprägungen und die folgenden äquivalenten Bedingungen erfüllt sind:

Anmerkung Unabhängigkeit

[Bearbeiten]Die Bedingung besagt, dass die Merkmalsausprägung "unter der Bedingung " (d.h. wenn man nur die Untersuchungseinheiten betrachtet, bei denen ist) die gleiche relative Häufigkeit hat, die sie auch insgesamt hat. Man könnte sagen: Das Auftreten von hat keinen Einfluss auf das Auftreten von .

Dieses Konzept der Unabhängigkeit ist allerdings für die Praxis nicht zu gebrauchen. Die Bedingung wird im Allgemeinen nicht erfüllt sein, selbst wenn die beiden Merkmale offensichtlich unabhängig voneinander sind.

Beispiel Unabhängigkeit

[Bearbeiten]Ein Würfel und eine Münze werden -mal geworfen (jeweils gleichzeitig). Das Merkmal gibt die Zahl des Würfels an, das Merkmal das Ergebnis des Münzwurfs. Es ergibt sich die folgende Kontingenztabelle:

Beispiel Unabhängigkeit II

[Bearbeiten]Daraus erhält man beispielsweise:

sowie und

sowie und

Die Merkmale und sind also nicht unabhängig.

Beispiel Unabhängigkeit III

[Bearbeiten]Aber:

Man kann hier sicher davon ausgehen, dass sich der Würfel- und der Münzwurf gegenseitig nicht beeinflussen und daher als unabhängig anzusehen sind. Die beobachteten Unterschiede zwischen den relativen Häufigkeiten und den bedingten relativen Häufigkeiten, können hier nur als zufällige Abweichungen erklärt werden.

Frage:

Wie kann man man in einem realen Fall (zum Beispiel in 1.2) entscheiden, ob die berechnete Abhängigkeit zwischen zwei Merkmalen auf Zufall oder auf einen tatsächlich vorhandenen Zusammenhang zurückzuführen ist?

Beispiel Unabhängigkeit III

[Bearbeiten]Innerhalb der schließenden Statistik gibt es Methoden, mit denen man die Unabhängigkeit zweier Größen untersuchen kann. Dabei betrachtet man die Unterschiede zwischen den relativen Häufigkeiten und den bedingten relativen Häufigkeiten auch quantitativ. Außerdem spielt die Zahl der vorhandenen Daten eine wichtige Rolle — bei großem werden die Abweichungen mit höherer Wahrscheinlichkeit klein ausfallen, daher müssen sie dann stärker gewichtet werden. Diese Fragen werden in der Vorlesung ’Statistik für Anwender II’ behandelt.

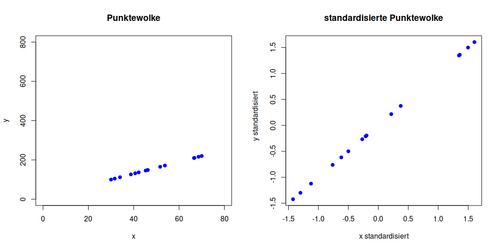

Punktwolke

[Bearbeiten]Für verbundene quantitative Merkmale nennt man ein Koordinatensystem mit den Punkten für Punktewolke zu und .

Beispiel Punktwolke

[Bearbeiten]Urliste

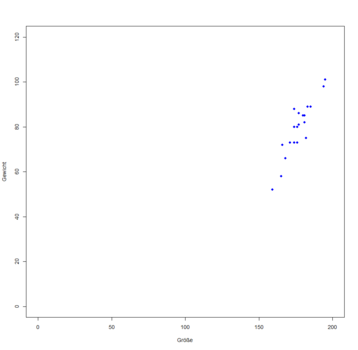

[Bearbeiten]Wir betrachten die Merkmale Größe (cm) und Gewicht (kg) auf einer Menge von Personen mit der folgenden Urliste:

Punktwolke

[Bearbeiten]Dabei ergibt sich die folgende Punktewolke (mit verschiedenen Skalierungen der Achsen):

Um eine von der Skalierung der Achsen unabhängige Darstellung zu erhalten, kann man die Merkmale standardisieren (vergleiche [Merkmale]). Die Punktewolke zu und nennt man dann die standardisierte Punktewolke zu und .

Urliste für standardisiertes Merkmal

[Bearbeiten]In obigem Beispiel ergibt sich für die standardisierten Merkmale und :

Standardisierte Punktewolke

[Bearbeiten]Damit erhält man die standardisierte Punktewolke:

Punktwolke: Anforderung an Skala

[Bearbeiten]Punktewolken sind nur für quantitative Merkmale sinnvoll, da die Skalierungen der Achsen bestimmte Abstände zwischen den verschiedenen Merkmalsausprägungen suggerieren.

Punktwolke: Erstellung in R

[Bearbeiten]In R: Man erstellt Vektoren x und y mit den Daten von und und kann dann mit plot(x,y) eine Punktewolke zu erzeugen.

Pearsonscher Korrelationskoeffizient

[Bearbeiten]Linearer Zusammenhang zwischen zwei Merkmalen

[Bearbeiten]Gesucht ist eine Methode zur Feststellung, ob zwei verbundene quantitative Merkmale auf eine der beiden folgenden Arten zusammenhängen:

- mit ( sind positiv korreliert)

Dabei gilt: Je größer ist, desto größer ist . - mit ( sind negativ korreliert)

Dabei gilt: Je größer ist, desto kleiner ist .

Linearer Zusammenhang und Punktwolke

[Bearbeiten]Betrachten wir die standardisierte Punktewolke zu und .

- Liegen entsprechende Werte für und gleichviele Standardabweichungen über bzw. unter dem Mittelwert, so erhält man einen Punkt auf der ersten Winkelhalbierenden.

- Liegt ein Wert für gleichviele Standardabweichungen über bzw. unter dem Mittelwert wie der entsprechenden Wert von darunter (und umgekehrt), so erhält man einen Punkt auf der zweiten Winkelhalbierenden.

Produkt der standardisierten Beobachtungswerte

[Bearbeiten]Im Allgemeinen liegen die Punkte natürlich nicht genau auf einer der Winkelhalbierenden. Man betrachtet das Produkt der standardisierten Beobachtungswerte zum selben Merkmalsträger . Dieses ist

- positiv, wenn überdurchschnittliche Werte von und zusammenfallen und wenn unterdurchschnittliche Werte von und zusammenfallen.

- negativ, wenn überdurchschnittliche Werte von mit unterdurchschnittlichen Werten von zusammenfallen oder umgekehrt.

Bestimmung des Pearsonschen Korrelationskoeffizient

[Bearbeiten]Man summiert für alle vorhandenen Merkmalsträger und teilt das Ergebnis durch die Anzahl der Punkte (man bildet also das arithmetische Mittel der Produkte der standardisierten Beobachtungswerte). Man definiert:

Für zwei verbundene quantitative Merkmale heißt

Pearsonscher Korrelationskoeffizienten von und .

Zusammenhnag Korrelationskoeffizient und Kovarianz

[Bearbeiten]Es gilt:

Man nennt den Zähler auf der rechten Seite auch Kovarianz von und : Offenbar gilt .

Beispiel Pearsonscher Korrelationskoeffizient

[Bearbeiten]Für die beiden Merkmale ’Größe’ und ’Gewicht’ aus [wolke] gilt:

Pearsonscher Korrelationskoeffizient und Art des linearen Zusammenhangs

[Bearbeiten]Es gilt stets , wobei:

Ein Korrelationskoeffizient nahe bei deutet also an, dass ein positiver linearer Zusammenhang zwischen den beiden Merkmalen besteht. (In obigem Beispiel zeigt der Korrelationskoeffizienten also einen positiven linearen Zusammenhang zwischen und .) Umgekehrt deutet ein Korrelationskoeffizient nahe bei an, dass ein negativer linearer Zusammenhang zwischen den beiden Merkmalen besteht.

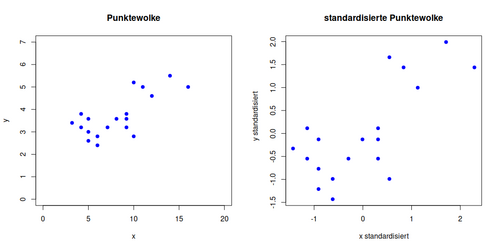

Beispiel 1

[Bearbeiten]Korrelationskoeffizient:

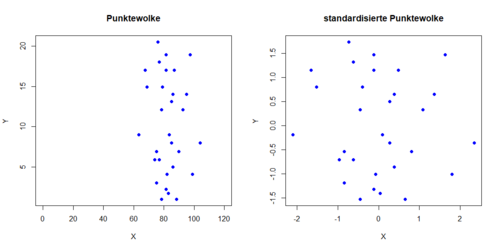

Beispiel 2

[Bearbeiten]Korrelationskoeffizient:

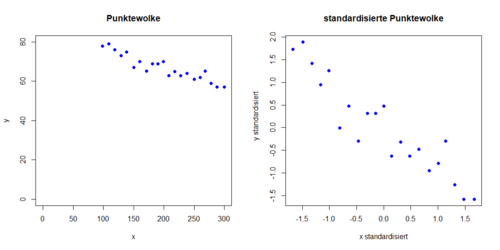

Beispiel 3

[Bearbeiten]Korrelationskoeffizient:

Beispiel 4

[Bearbeiten]Korrelationskoeffizient:

Beispiel 5

[Bearbeiten]Korrelationskoeffizient:

Beispiel 6

[Bearbeiten]Korrelationskoeffizient:

Korrelation und Ursache-Wirkungs-Prinzip

[Bearbeiten]Auch wenn oder ist, lässt sich keine Aussage über ein "Ursache-Wirkungs-Prinzip" zwischen den beiden Größen machen. Es ist denkbar, dass eine direkt auf die Andere einwirkt. Beide Größen könnten aber auch von weiteren Umständen in gleicher (oder entgegengesetzter) Weise beeinflusst werden, oder es könnte sogar ein kompliziertes Netz von Ursachen und Wirkungen zwischen vielen verschiedenen Faktoren bestehen. Zusätzlich ist es möglich, dass der aufgrund des Korrelationskoeffizienten vermutete Zusammenhang lediglich auf Zufall zurückzuführen ist. Der Korrelationskoeffizient beschreibt (wie alles in der beschreibenden Statistik) nur die vorhandenen Daten. Diese hängen von der zufällig ausgewählten Grundgesamtheit ab.

Korrelationskoeffizient nahe 0

[Bearbeiten]Ein Korrelationskoeffizient nahe kann bedeuten, dass die Merkmale unabhängig voneinander sind. Genauer bedeutet es aber, dass kein linearer Zusammenhang zwischen beiden Merkmalen festgestellt wurde:

Nimmt ein Merkmal die Werte an und ist , so ergibt sich , obwohl und ganz und gar nicht unabhängig sind ( lässt sich ja aus berechnen).

Berechnung des Korrelationskoeffizienten in R

[Bearbeiten]In R: Man erstellt Vektoren x und y mit den Daten von und und kann dann mit cor(x,y) den Korrelationskoeffizienten berechnen.

Rangkorrelationskoeffizient von Spearman

[Bearbeiten]Um einen monotonen Zusammenhang zwischen zwei Merkmalen nachzuweisen, kann der Rangkorreltaionskoeffizient von Spearman verwendet werden. Hierfür muss zunächst der Rang , also die Stelle festgestellt werden, an welcher die Beobachtung in der geordneten Urliste steht. Wenn die Beobachtung mehrfach auftritt, wird der Durchschittsrang verwendet.

Beispiel Bestimmung des Ranges

[Bearbeiten]Gegeben seien die Merkmale Daraus ergeben sich die Rangsummen

Definition Rangkorreltaionskoeffizient

[Bearbeiten]Der Rangkorreltaionskoeffizient ergibt sich aus den den Rängen des Merkmals und den Rängen des Merkmals mit einer Stichprobengröße :

Wenn keine Bindungen (Mehrfachauftreten von Werten) vorliegen, kann der Rangkorrelationskoeffizient auch bestimmt werden durch:

Rangkorrelationskoeffizient und Art des Zusammenhangs

[Bearbeiten]Besteht ein perfekt monoton wachsender Zusammenhang zwischen den beiden Merkmalen, so ist . Ist hingegen , so liegt ein perfekt fallender monotoner Zusammenhang vor.

Beispiel Bestimmung des Rangkorrelationskoeffizient

[Bearbeiten]Es werden die Noten im Abitur und vom Bachelor von Studierenden betrachtet und es soll ermittelt werden, ob ein monotoner Zusammenhang vorliegt:

Daraus ergeben sich die folgenden Ränge:

und daraus resultierend ein Rangkorrelationskoeffizient

Rangkorrelationskoeffizient und Ursache-Wirkungs-Prinzip

[Bearbeiten]Ebenso wie beim Pearsonschen Korrelationskoeffizient bedeutet eine perfekt monoton fallender oder wachsender Zusammenhang nicht direkt ein Ursache-Wirkungs-Prinzip.

Berechnung Rangkorrelationskoeffizient in R

[Bearbeiten]In R: Um den Rangkorrelationskoeffizient nach Spearman zu bestimmen, geht man vor wie beim Pearsonschen Korrelationskoeffizient und nutzt das zusätzlichen Argument method = spearman : Man erstellt also Vektoren x und x mit den Daten von und und erhält mit cor(x,y,method="spearman") den Rangkorrelationskoeffizienten nach Spearman.

Lineare Regression

[Bearbeiten]Seien quantitative Merkmale mit einem Korrelationskoeffizienten . Dann kann man von einem ungefähren linearen Zusammenhang zwischen und ausgehen. Es existieren also (mit ) mit .

Bestimmung der Regressionsgeraden

[Bearbeiten]Wir wollen nun so bestimmen, dass diese Approximation möglichst gut ist. Eine Möglichkeit besteht darin, die Summe der Quadrate der Abweichungen

durch geeignete Wahl von und zu minimieren. Dies gelingt mit

Die Gerade mit der Gleichung

heißt Gerade der linearen Regression von auf (Regressionsgerade), ihre Steigung Regressionskoeffizient.

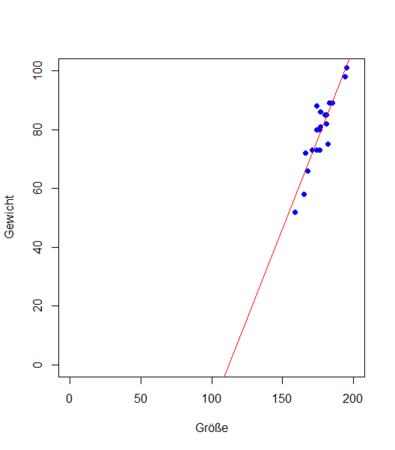

Beispiel Bestimmung der Regressionsgeraden

[Bearbeiten]Für die beiden Merkmale ’Größe’ und ’Gewicht’ aus [wolke] gilt:

Die Gerade mit der Gleichung in der Punktewolke von und :

Regressionsgerade und Ursache-Wirkungs-Prinzip

[Bearbeiten]Die Berechnung der Regressionsgeraden von auf ist nur dann sinnvoll, wenn man begründet davon ausgehen kann, dass (in linearer Weise) von abhängt ( ist also Ursache und Wirkung).

Trendgröße und Realgröße

[Bearbeiten]Aus dem Prädiktor lässt sich die Trendgröße berechnen. Sie gibt an, welchen Wert man für erwarten kann, wenn man den entsprechenden Wert von zugrundelegt. Da aber neben noch weitere Umstände auf einwirken, gibt es einen Unterschied zwischen Trendgröße und der Realgröße . Die Trendgröße kann aber eine sinnvolle Annäherung an die Realgröße sein, insbesondere bei einem Korrelationskoeffizienten nahe (bzw. wenn eine lineare Abhängigkeit plausibel ist). Man sollte auch überlegen, für welche Werte von eine Berechnung von Sinn überhaupt macht.

Beispiel Trendgröße und Realgröße

[Bearbeiten]In obigem Beispiel ist .

Damit berechnet man:

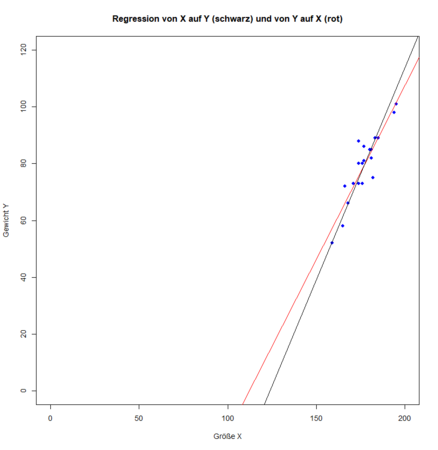

Vergleich Regression X auf Y und Y auf X

[Bearbeiten]Es ist natürlich auch möglich als Prädiktor (Ursache) anzusehen und die Regressionsgerade von auf zu bestimmen. Ein Vergleich der beiden Regressionsgeraden ergibt:

X ist Prädiktor

[Bearbeiten]Gerade der linearen Regression von auf :

Y ist Prädiktor

[Bearbeiten]Gerade der linearen Regression von auf :

Auswahl des Prädiktor

[Bearbeiten]Beide Geraden stimmen nur dann überein, wenn ist.

Es macht also einen Unterschied, welche der beiden Größen man als Ursache und welche als Wirkung ansieht. Vor der Berechnung einer Regressionsgeraden sollte man dazu Überlegungen anstellen.

Beispiel Vergleich Regression X auf Y und Y auf X

[Bearbeiten]In obigem Beispiel ist .

Also ergibt die Regression von auf : bzw. äquivalent . Das folgende Diagramm zeigt die Punktewolke mit beiden Regressionsgeraden:

Hierbei scheint die Regression des Gewichts auf die Größe mehr Sinn zu machen, da die Größe Auswirkungen auf das Gewicht hat, aber nicht umgekehrt.

Aufgabe I

[Bearbeiten]In einer Studie zur Untersuchung von Herzkreislauferkrankungen wurde bei 6 Männern der Body-Maß-Index (BMI Gewicht in kg/(Körpergröße in cm)) ermittelt und der (systolische) Blutdruck gemessen. Es wurden folgende Daten ermittelt:

- Stellen Sie die Gleichung der Regressionsgerade von auf auf und zeichnen Sie die Gerade in die Punktewolke ein.

- Stellen Sie auch die Gleichung der Regressionsgerade von auf auf und zeichnen Sie die Gerade in die Punktwolke ein.

- Vergleichen sie die beiden Regressionsgeraden.

- Welchen Blutdruck erwartet man (gemäß dieser Geraden), bei einem BMI von bzw. von . Begründen Sie, welchen dieser beiden Werte Sie eher als zuverlässige Schätzung ansehen würden?

- Beurteilen Sie die Anwendbarkeit der Modelle.

- Bestimmen Sie beide Korrelationskoeffizienten (Pearson und Spearman) von und .

- Welche Gemeinsamkeiten/Unterschiede gibt es zwischen Spearman’s Rho und dem Korrelationskoeffizient nach Pearson?

Aufgabe I Fortsetzung

[Bearbeiten]Aufgabe II

[Bearbeiten]Bearbeiten Sie zur Wiederholung von Kapitel 1 die Aufgabe im R-Skript im Materialordner. Rechnen Sie die Aufgaben sowohl mit R als auch "zu Fuß".

Seiteninformation

[Bearbeiten]Diese Lernresource können Sie als Wiki2Reveal-Foliensatz darstellen.

Wiki2Reveal

[Bearbeiten]Dieser Wiki2Reveal Foliensatz wurde für den Lerneinheit Kurs:Statistik für Anwender' erstellt der Link für die Wiki2Reveal-Folien wurde mit dem Wiki2Reveal-Linkgenerator erstellt.

- Die Seite wurde als Dokumententyp PanDocElectron-SLIDE erstellt.

- Link zur Quelle in Wikiversity: https://de.wikiversity.org/wiki/Kurs:Statistik%20f%C3%BCr%20Anwender/Darstellung%20und%20Korrelation%20f%C3%BCr%20mehrere%20Merkmale

- siehe auch weitere Informationen zu Wiki2Reveal und unter Wiki2Reveal-Linkgenerator.