Kurs:Stochastik/Verteilungsfunktion

Definition

[Bearbeiten]Eine Verteilungsfunktion kann über

- ein Wahrscheinlichkeitsmaß oder

- eine Zufallsvariable definieren

Definition mittels Wahrscheinlichkeitsmaß

[Bearbeiten]Gegeben sei ein Wahrscheinlichkeitsmaß auf dem Ereignisraum der reellen Zahlen, d. h., jede reelle Zahl kann als mögliches Ergebnis aufgefasst werden. Dann heißt die Funktion

definiert durch

die Verteilungsfunktion von . Mit anderen Worten: Die Funktion gibt an der Stelle an, mit welcher Wahrscheinlichkeit ein Ergebnis aus der Menge (alle reellen Zahlen kleiner oder gleich ) eintritt.

Definition mittels Zufallsvariable

[Bearbeiten]Ist eine reelle Zufallsvariable, so nennt man die Funktion

die Verteilungsfunktion von . Dabei bezeichnet die Wahrscheinlichkeit, dass einen Wert kleiner oder gleich annimmt.

Somit ist die Verteilungsfunktion einer Zufallsvariable genau die Verteilungsfunktion ihrer Verteilung.

Beispiele

[Bearbeiten]Wahrscheinlichkeitsmaße mit Dichten

[Bearbeiten]Besitzt das Wahrscheinlichkeitsmaß eine Wahrscheinlichkeitsdichte , so gilt

- .

Somit hat in diesem Fall die Verteilungsfunktion die Darstellung

Diese Integraldarstellung im Sinne der Analysis ist im Allgemeinen aber nicht gegeben.

Dichte der Exponentialverteilung

[Bearbeiten]Beispielsweise hat die Exponentialverteilung die Dichte

- .

Ist also die Zufallsvariable exponentialverteilt, also , so ist

- .

Allgemeine Dichtefunktion

[Bearbeiten]Nicht alle Wahrscheinlichkeitsmaße auf den reellen Zahlen besitzen eine Dichtefunktion bzgl. des Lebesgue-Maßes. Beispielsweise haben diskrete Verteilungen, aufgefasst als Verteilungen in ) keine integrable Dichtefunktion. Dafür muss man den Begriff der Dichte verallgemeinern und zu einer Dichte bzgl. eines dominierenden Maßes wählen. Für diskrete Verteilung kann man dann wieder eine Dichte bzgl. des Zählmaßes angeben.

Verteilungsfunktionen und Stammfunktionen

[Bearbeiten]Für integrable Dichtefunktion muss nicht notwendigerweise eine Stammfunktion mit geschlossener Darstellung existieren. Eine Stammfunktion kann beispielsweise bei der Normalverteilung nicht angegeben werden.

Diskrete Wahrscheinlichkeitsmaße

[Bearbeiten]Betrachtet man zu einem Parameter eine Bernoulli-verteilte Zufallsvariable , so ist

und für die Verteilungsfunktion folgt dann

Wahrscheinlichkeit durch Elementarreignissen ausdrücken

[Bearbeiten]Ist allgemeiner eine Zufallsvariable auf mit Werten in den nichtnegativen ganzen Zahlen , dann gilt

- .

Dabei bezeichnet die Abrundungsfunktion, das heißt ist größte ganze Zahl, die kleiner oder gleich ist.

Eigenschaften und Zusammenhang zur Verteilung

[Bearbeiten]

Eigenschaften der Verteilungsfunktion

[Bearbeiten]Jede Verteilungsfunktion hat folgende Eigenschaften:

- ist monoton steigend.

- ist rechtsseitig stetig.

- und .

Drei Eigenschaften liefern Verteilungsfunktion

[Bearbeiten]Darüber hinaus ist jede Funktion , die die Eigenschaften 1, 2 und 3 erfüllt, eine Verteilungsfunktion. Folglich ist eine Charakterisierung der Verteilungsfunktion mit Hilfe der drei Eigenschaften möglich.

Korrespondenzsatz

[Bearbeiten]Es gibt zu jeder Verteilungsfunktion genau solch ein Wahrscheinlichkeitsmaß , dass für alle gilt:

Umgekehrt gibt es zu jedem Wahrscheinlichkeitsmaß eine Verteilungsfunktion derart, dass für alle gilt:

Daraus folgt die Korrespondenz von und . Dieser Sachverhalt wird in der Literatur auch Korrespondenzsatz genannt.[1]

Sprungstellen der Verteilungsfunktion

[Bearbeiten]Jede Verteilungsfunktion besitzt höchstens abzählbar viele Sprungstellen.

Da jede Verteilungsfunktion rechtsstetig ist, existiert auch der rechtsseitige Grenzwert und es gilt für alle :

Deswegen ist genau dann stetig, wenn für alle gilt.

Rechnen mit Verteilungsfunktionen

[Bearbeiten]Ist eine Verteilungsfunktion gegeben, so kann man wie folgt die Wahrscheinlichkeiten bestimmen:

- sowie bzw.

- sowie .

Berechnung der Wahrscheinlickeit von Intervallen

[Bearbeiten]Insgesamt kann man mit Verteilungsfunktion auch die Wahrscheinlichkeit von halboffenen Intervallen berechnen:

- und

für .

Ungleichungen für diskrete Zufallsgröße

[Bearbeiten]Im Allgemeinen kann hier die Art der Ungleichheitszeichen ( oder ) beziehungsweise die Art der Intervallgrenzen (offen, abgeschlossen, links/rechts halboffen) nicht vernachlässigt werden. Dies führt besonders bei diskreten Wahrscheinlichkeitsverteilungen zu Fehlern, da sich dort auch auf einzelnen Punkten eine Wahrscheinlichkeit befinden kann, die dann versehentlich dazugezählt oder vergessen wird.

Ungleichungen für stetige Zufallsgröße

[Bearbeiten]Bei stetigen Wahrscheinlichkeitsverteilungen, also insbesondere auch bei solchen, die über eine Wahrscheinlichkeitsdichtefunktion definiert werden (Absolutstetige Wahrscheinlichkeitsverteilungen), führt eine Abänderung der Ungleichheitszeichen oder Intervallgrenzen nicht zu Fehlern, d.h.

Beispiel

[Bearbeiten]Beim Würfeln errechnet sich die Wahrscheinlichkeit, eine Zahl zwischen 2 (exklusive) und einschließlich 5 zu würfeln, zu

- .

Konvergenz

[Bearbeiten]Definition

[Bearbeiten]Eine Folge von Verteilungsfunktionen heißt schwach konvergent gegen die Verteilungsfunktion , wenn

- gilt für alle , an denen stetig ist.[2]

Für Verteilungsfunktionen von Zufallsvariablen finden sich auch die Bezeichnungen konvergent in Verteilung oder stochastisch konvergent.[3]

Eigenschaften

[Bearbeiten]Über die schwache Konvergenz der Verteilungsfunktionen lässt sich mit dem Satz von Helly-Bray eine Brücke zur schwachen Konvergenz von Maßen schlagen. Denn eine Folge von Wahrscheinlichkeitsmaßen ist genau dann schwach konvergent, wenn die Folge ihrer Verteilungsfunktionen schwach konvergiert. Analog ist eine Folge von Zufallsvariablen genau denn Konvergent in Verteilung, wenn die Folge ihrer Verteilungsfunktionen schwach konvergiert.

Für Verteilungsfunktionen im Sinne der Maßtheorie ist die oben angegebene Definition nicht korrekt, sondern entspricht der vagen Konvergenz von Verteilungsfunktionen (im Sinne der Maßtheorie). Diese fällt aber für Wahrscheinlichkeitsmaßen mit der schwachen Konvergenz von Verteilungsfunktionen zusammen. Die schwache Konvergenz von Verteilungsfunktionen wird von dem Lévy-Abstand metrisiert.

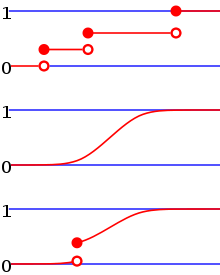

Klassifikation von Verteilungsfunktionen

[Bearbeiten]Wahrscheinlichkeitsverteilungen, deren Verteilungsfunktion stetig ist, werden stetige Wahrscheinlichkeitsverteilungen genannt. Sie lassen sich noch weiter unterteilen in

- Absolutstetige Wahrscheinlichkeitsverteilungen, für die eine Wahrscheinlichkeitsdichtefunktion existiert. Typische Beispiele hierfür wäre die Normalverteilung oder die Exponentialverteilung.

- Stetigsinguläre Wahrscheinlichkeitsverteilungen, die keine Wahrscheinlichkeitsdichtefunktion besitzen. Beispiel hierfür wäre die Cantor-Verteilung.

Ableitung der Verteilungsfunktion

[Bearbeiten]Für absolutstetige Wahrscheinlichkeitsverteilungen entspricht die Ableitung der Verteilungsfunktion der Wahrscheinlichkeitsdichtefunktion. Zwar sind auch absolutstetige Wahrscheinlichkeitsverteilungen fast überall differenzierbar, ihre Ableitung ist aber fast überall gleich null.

Verteilungsfunktionen von diskreten Wahrscheinlichkeitsverteilungen zeichnen sich durch ihre Sprünge zwischen den Bereichen mit konstanten Funktionswerten aus. Bei ihnen handelt es sich um Treppenfunktionen.

Alternative Definition

[Bearbeiten]Linksseitig stetige Verteilungsfunktionen

[Bearbeiten]Im Einflussbereich der Tradition Kolmogorows, namentlich der mathematischen Literatur des ehem. „Ostblocks“, findet sich parallel zur heute vorherrschenden „Kleiner-gleich“-Konvention der Verteilungsfunktion bis in die jüngere Vergangenheit eine weitere, die statt des Kleiner-gleich-Zeichens das Echt-kleiner-Zeichen verwendet,[4][5] also

Bei stetigen Wahrscheinlichkeitsverteilungen stimmen beide Definitionen überein, bei diskreten Verteilungen dagegen unterscheiden sie sich darin, dass die Verteilungsfunktion im Fall der „Echt-kleiner“-Konvention an den Sprungstellen nicht rechtsseitig, sondern linksseitig stetig ist.

Beispiel

[Bearbeiten]Es ergibt sich beispielsweise für die Binomialverteilung bei der heute üblichen „Kleiner-gleich“-Konvention eine Verteilungsfunktion der Form

- ,

bei der „Echt-kleiner“-Konvention dagegen die Schreibweise

- .

Speziell für gilt im zweiten Fall also[6]

- .

Verwandte Konzepte

[Bearbeiten]Empirische Verteilungsfunktion

[Bearbeiten]Die empirische Verteilungsfunktion einer Stichprobe spielt eine wichtige Rolle in der Statistik. Formal entspricht sie der Verteilungsfunktion einer diskreten Gleichverteilung auf den Punkten . Ihre Bedeutung hat sie daher, dass nach dem Satz von Gliwenko-Cantelli die empirische Verteilungsfunktion einer unabhängigen Stichprobe von Zufallszahlen gegen die Verteilungsfunktion der Wahrscheinlichkeitsverteilung konvergiert, mittels der die Zufallszahlen erzeugt wurden.

Gemeinsame Verteilungsfunktion und Rand-Verteilungsfunktionen

[Bearbeiten]Die Gemeinsame Verteilungsfunktion verallgemeinert das Konzept einer Verteilungsfunktion von der Verteilung einer Zufallsvariablen auf die Gemeinsame Verteilung von Zufallsvariablen. Ebenso lässt sich das Konzept von der Randverteilung zur Rand-Verteilungsfunktion übertragen. Diese Verteilungsfunktionen haben gemeinsam, dass ihr Definitionsbereich der ist für

Verallgemeinerte Inverse Verteilungsfunktion

[Bearbeiten]Die Verallgemeinerte inverse Verteilungsfunktion bildet unter Umständen eine Umkehrfunktion zur Verteilungsfunktion und ist wichtig zur Bestimmung von Quantilen.

Verteilungsfunktion im Sinne der Maßtheorie

[Bearbeiten]Verteilungsfunktionen können nicht nur für Wahrscheinlichkeitsmaße definiert werden, sondern für beliebige endliche Maße auf den reellen Zahlen. In diesen Verteilungsfunktionen (im Sinne der Maßtheorie) spiegeln sich dann wichtige Eigenschaften der Maße wider. Sie bilden eine Verallgemeinerung der hier besprochenen Verteilungsfunktionen.

Überlebensfunktion

[Bearbeiten]Die Überlebensfunktion gibt im Gegensatz zu einer Verteilungsfunktion an, wie groß die Wahrscheinlichkeit ist, einen gewissen Wert zu Überschreiten. Sie tritt beispielsweise bei der Modellierung von Lebensdauern auf und gibt dort an, wie groß die Wahrscheinlichkeit ist, einen gewissen Zeitpunkt zu „überleben“.

Multivariate und mehrdimensionale Verteilungsfunktion

[Bearbeiten]Die Multivariate Verteilungsfunktion ist die Verteilungsfunktion, die multivariaten Wahrscheinlichkeitsverteilungen zugeordnet wird. Als mehrdimensionale Verteilungsfunktion wird hingegen meist die das höherdimensionale Pendant der Verteilungsfunktion im Sinne der Maßtheorie bezeichnet.

Allgemeine Informationen

[Bearbeiten]Die Verteilungsfunktion ist eine spezielle reelle Funktion in der Stochastik und ein zentrales Konzept bei der Untersuchung von Wahrscheinlichkeitsverteilungen auf den reellen Zahlen.

Beziehung Wahrscheinlichkeitsverteilung und Verteilungsfunktion

[Bearbeiten]Jeder Wahrscheinlichkeitsverteilung und jeder reellwertigen Zufallsvariable kann eine Verteilungsfunktion zugeordnet werden. Anschaulich entspricht dabei der Wert der Verteilungsfunktion an der Stelle der Wahrscheinlichkeit, dass die zugehörige Zufallsvariable einen Wert kleiner oder gleich annimmt. Ist beispielsweise die Verteilung der Schuhgrößen in Europa gegeben, so entspricht der Wert der entsprechenden Verteilungsfunktion bei 45 der Wahrscheinlichkeit, dass ein beliebiger Europäer die Schuhgröße 45 oder kleiner besitzt.

Korrespondenzsatz

[Bearbeiten]Ihre Bedeutung erhält die Verteilungsfunktion durch den Korrespondenzsatz, der besagt, dass jeder Verteilungsfunktion eine Wahrscheinlichkeitsverteilung auf den reellen Zahlen zugeordnet werden kann und umgekehrt. Die Zuordnung ist bijektiv. Dies ermöglicht es, anstelle der Untersuchung von Wahrscheinlichkeitsverteilungen als Mengenfunktionen auf einem komplexen Mengensystem mit Methoden der Maßtheorie die entsprechenden Verteilungsfunktionen zu untersuchen. Diese sind reelle Funktionen und somit über die Methoden der reellen Analysis leichter zugänglich.

Univerariate und multivariate Verteilungsfunktion

[Bearbeiten]Als alternative Bezeichnungen finden sich unter anderem kumulierte Verteilungsfunktion, da sie die Wahrscheinlichkeiten kleiner als zu sein anhäuft, siehe auch kumulierte Häufigkeit. Des Weiteren wird sie zur besseren Abgrenzung von ihrem höherdimensionalen Pendant, der multivariaten Verteilungsfunktion, auch als univariate Verteilungsfunktion bezeichnet.[7] In Abgrenzung zum allgemeineren Maßtheoretischen Konzept einer Verteilungsfunktion finden sich die Bezeichnungen als wahrscheinlichkeitstheoretische Verteilungsfunktion oder als Verteilungsfunktion im engeren Sinn.[8]

Empirische Verteilungsfunktion

[Bearbeiten]Die Entsprechung der Verteilungsfunktion in der deskriptiven Statistik ist die empirische Verteilungs- oder Summenhäufigkeitsfunktion

Literatur

[Bearbeiten]- Klaus D. Schmidt: Maß und Wahrscheinlichkeit. 2., durchgesehene Auflage. Springer-Verlag, Heidelberg / Dordrecht / London / New York 2011, ISBN 978-3-642-21025-9, doi:10.1007/978-3-642-21026-6.

- Achim Klenke: Wahrscheinlichkeitstheorie. 3. Auflage. Springer-Verlag, Berlin / Heidelberg 2013, ISBN 978-3-642-36017-6, doi:10.1007/978-3-642-36018-3.

- Norbert Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. Eine Einführung. 2., überarbeitete und erweiterte Auflage. Springer-Verlag, Berlin / Heidelberg 2014, ISBN 978-3-642-45386-1, doi:10.1007/978-3-642-45387-8.

Einzelnachweise

[Bearbeiten]- ↑ N. Schmitz. Vorlesungen über Wahrscheinlichkeitstheorie. Teubner, 1996.

- ↑ Schmidt: Maß- und Wahrscheinlichkeit. 2011, S. 396.

- ↑ Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. 2014, S. 287.

- ↑ Alexandr Alexejewitsch Borowkow: Rachunek prawdopodobieństwa. Państwowe Wydawnictwo Naukowe, Warszawa 1977, S. 36 ff.

- ↑ Marek Fisz: Wahrscheinlichkeitsrechnung und mathematische Statistik. VEB Deutscher Verlag der Wissenschaften, Elfte Auflage, Berlin 1989, Definition 2.2.1, S. 51.

- ↑ W. Gellert, H. Küstner, M. Hellwich, H. Kästner (Hrsg.): Kleine Enzyklopädie Mathematik. VEB Verlag Enzyklopädie Leipzig 1970, OCLC 174754758, S. 659–660.

- ↑ Schmidt: Maß- und Wahrscheinlichkeit. 2011, S. 246.

- ↑ Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. 2014, S. 62.

Seiten-Information

[Bearbeiten]Dieser Wiki2Reveal Foliensatz wurde für den Lerneinheit Kurs:Stochastik' erstellt der Link für die Wiki2Reveal-Folien wurde mit dem Wiki2Reveal-Linkgenerator erstellt.

Wiki2Reveal

[Bearbeiten]- Die Inhalte der Seite basieren auf den folgenden Inhalten:

- Die Seite wurde als Dokumententyp PanDocElectron-SLIDE erstellt.

- Link zur Quelle in Wikiversity: https://de.wikiversity.org/wiki/Kurs:Stochastik/Verteilungsfunktion

- siehe auch weitere Informationen zu Wiki2Reveal und unter Wiki2Reveal-Linkgenerator.

Wikiversity2Wikipedia

[Bearbeiten]Diese Seite wurde auf Basis der folgenden Wikipedia-Quelle erstellt:

![{\displaystyle F_{P}\colon \mathbb {R} \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d2e428d6aaa54fa25289ec92f0fe95e8057387e)

![{\displaystyle F_{P}(x)=P((-\infty ,x])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bef8e83eb5201467cbb2dcd0afe44971d70ca95a)

![{\displaystyle (-\infty ,x]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ad2402c0ff48631309599dc5d8be7607fb994d8d)

![{\displaystyle P((a,b])=\int _{a}^{b}f_{P}(x)\,\mathrm {d} x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ddd9cfff49a23ceb40a6bb483b3f06bd5aa24b84)

![{\displaystyle F\colon \mathbb {R} \rightarrow [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b4c45b6faf38bb3fb300ab4678d3675afd172f56)

![{\displaystyle P_{F}\colon {\mathcal {B}}(\mathbb {R} )\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f028a26b4d83d4e753de7e2f078ae55d55904097)

![{\displaystyle P_{F}\left(]-\infty ,x]\right)=F(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1a1576e643e0cf9c3848df80fae46fac65f09378)

![{\displaystyle P\colon {\mathcal {B}}(\mathbb {R} )\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/914424c5a0da8466438e221a5d22de2aab4ef610)

![{\displaystyle F_{P}\colon \mathbb {R} \rightarrow [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f8c0dd4c1038f93abe968e70d19b188b7f29332c)

![{\displaystyle P\left(]-\infty ,x]\right)=F_{P}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0405857991ccd542fbd42ff0857e57154b7a084b)

![{\displaystyle P((-\infty ;a])=F(a)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3c87fb872c6a3251f82fd21f908111708d1489a8)

![{\displaystyle P((a;b])=F(b)-F(a)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fcc1d1c84afe5749824309e68d2c1aa581dcf21d)